Google Cloud 認定資格 – Professional Cloud Developer – 模擬問題集(全 255問)

Question 001

データ移行の一環として、オンプレミスの仮想マシンから Google Cloud Storage にファイルをアップロードしたいと考えています。

これらのファイルは GCP 環境の Dataproc Hadoop クラスタによって使用されます。

どのコマンドを使用するべきですか?

- A. gsutil cp [LOCAL_OBJECT] gs://[DESTINATION_BUCKET_NAME]/

- B. gcloud cp [LOCAL_OBJECT] gs://[DESTINATION_BUCKET_NAME]/

- C. hadoop fs cp [LOCAL_OBJECT] gs://[DESTINATION_BUCKET_NAME]/

- D. gcloud dataproc cp [LOCAL_OBJECT] gs://[DESTINATION_BUCKET_NAME]/

Answer: A

gsutil cp コマンドはローカルファイル間のデータのコピーを可能にします。ストレージ。”gsutil config” の実行によって生成される boto ファイル。

Question 002

Google Cloud Platformにアプリケーションを移行し、既存の監視プラットフォームはそのまま使用しています。

今、通知システムが重要な問題に対して遅すぎることに気づきました。

どうしたらいいでしょうか?

- A. モニタリング プラットフォーム全体を Stackdriver に置き換えます。

- B. Compute Engine インスタンスに Stackdriver エージェントをインストールします。

- C. Stackdriver を使用してログをキャプチャしてアラートを出し、既存のプラットフォームに送信します。

- D. 一部のトラフィックを古いプラットフォームに戻し、2 つのプラットフォームで同時に AB テストを実行します。

Answer: A

Reference:

– Cloud Monitoring | Google Cloud

Question 003

MySQL データベースを Google Cloud のマネージド Cloud SQL データベースに移行することを計画しています。

この Cloud SQL インスタンスに接続する Compute Engine 仮想マシン インスタンスがあります。Cloud SQL にアクセスできるようにするために Compute Engine インスタンスの IP をホワイトリストに登録したくありません。

どうすればいいのでしょうか?

- A. Cloud SQL インスタンスのプライベート IP を有効にします。

- B. プロジェクトをホワイトリストに登録して Cloud SQL にアクセスし、ホワイトリストに登録されたプロジェクトに Compute Engine インスタンスを追加します。

- C. 外部インスタンスからデータベースへのアクセスを許可する役割を Cloud SQL で作成し、Compute Engine インスタンスをその役割に割り当てます。

- D. 1 つのプロジェクトで CloudSQL インスタンスを作成します。別のプロジェクトで Compute Engine インスタンスを作成します。これら 2 つのプロジェクト間に VPN を作成して、Cloud SQL への内部アクセスを許可します。

Answer: A

Reference:

– Cloud SQL 接続について | Cloud SQL for MySQL | Google Cloud

Question 004

gcloud コマンドで HTTP (S) ロードバランサをデプロイしています。

export NAME-load-balancer

#create network

gcloud compute networks create $(NAME}

#add instance.

gcloud compute instances create $ (NAME)-backend-instance-1 --subnet $(NAME -no address

# create the instance group

gcloud compute instance-groups unmanaged create ${NAME}-i

gcloud compute instance-groups unmanaged set-named-ports ${NAME}-i -named-ports http:80

gcloud compute instance-groups unmanaged add-instances $(NAME)-i-instances $(NAME)-instance-1

#configure health checks

gcloud compute health-checks create http $(NAME)-http-hc --port 80

# create backend service

gcloud compute backend-services create $(NAME)-http-bes --health-checks ${NAME}-http-hc --protocol HTTP --port-name http --global

gcloud compute backend-services add-backend $(NAME)-http-bes --instance-group $(NAME)-i-balancing-mode RATE --max-rate 100000 --capacity-scaler 1.0-global-instance-group-zone us-east1-d

# create urls maps and forwarding rule

gcloud compute url-maps create $(NAME)-http-urlmap --default-service ${NAME}-http-bes

gcloud compute target-http-proxies create $(NAME)-http-proxy --url-map $(NAME)-http-urlmap

gcloud compute forwarding-rules create $(NAME)-http-fw --global-ip-protocol ICP --target-http-proxy ${NAME}-http-proxy

-ports 80Compute Engine 仮想マシン インスタンスのポート 80 へのヘルス チェックが失敗し、インスタンスにトラフィックが送信されません。この問題を解決したいと思っています。

どのコマンドを実行するべきでしょうか?

- A. gcloud compute instances add-access-config ${NAME}-backend-instance-1

- B. gcloud compute instances add-tags ${NAME}-backend-instance-1 –tags http-server

- C. gcloud compute firewall-rules create allow-lb –network load-balancer –allow tcp –source-ranges 130.211.0.0/22,35.191.0.0/16 –direction INGRESS

- D. gcloud compute firewall-rules create allow-lb –network load-balancer –allow tcp –destination-ranges 130.211.0.0/22,35.191.0.0/16 –direction EGRESS

Answer: C

Reference:

– ネットワーキング ユースケース用に VM を構成する | VPC | Google Cloud

Question 005

Web サイトは Compute Engine にデプロイされています。

マーケティング チームは 3つの異なる Web サイトデザイン間のコンバージョン率をテストしたいと考えています。

どのアプローチを使用するべきでしょうか?

- A. App Engine に Web サイトをデプロイし、トラフィック分割を使用します。

- B. App Engine に Web サイトを 3つの独立したサービスとしてデプロイします。

- C. Cloud Functions に Web サイトをデプロイし、トラフィック分割を使用します。

- D. Cloud Functions に Web サイトを 3つの独立したサービスとしてデプロイします。

Answer: A

Reference:

– トラフィックの分割 | Python 2 の App Engine スタンダード環境 | Google Cloud

Question 006

ディレクトリ local-scripts とそのすべてのコンテンツをローカル ワークステーションから Compute Engine 仮想マシン インスタンスにコピーする必要があります。

どのコマンドを使用するべきでしょうか?

- A. gsutil cp –project my-gcp-project -r ~/local-scripts/ gcp-instance-name:~/server-scripts/ –zone us-east1-b

- B. gsutil cp –project my-gcp-project -R ~/local-scripts/ gcp-instance-name:~/server-scripts/ –zone us-east1-b

- C. gcloud compute scp –project my-gcp-project –recurse ~/local-scripts/ gcp-instance-name:~/server-scripts/ –zone us-east1-b

- D. gcloud compute mv –project my-gcp-project –recurse ~/local-scripts/ gcp-instance-name:~/server-scripts/ –zone us-east1-b

Answer: C

Reference:

– gcloud compute copy-files | Google Cloud CLI Documentation

Question 007

Stackdriver Monitoring Agent がインストールされた Compute Engine 仮想マシン インスタンスにアプリケーションをデプロイしています。

アプリケーションはインスタンス上の UNIX プロセスです。UNIX プロセスが少なくとも 5 分間実行されていない場合にアラートを受け取る必要があります。アプリケーションを変更してメトリックまたはログを生成することはできません。

どのアラート条件を構成する必要がありますか?

- A. Uptime check

- B. Process health

- C. Metric absence

- D. Metric threshold

Answer: B

Reference:

– 指標ベースのアラート ポリシーの動作 | Cloud Monitoring | Google Cloud

Question 008

ANSI-SQL 準拠のデータベースで同一のカラムを持つ 2 つのテーブルがあり、迅速に 1 つのテーブルに統合し、結果セットから重複する行を削除する必要があります。

どうすればよいでしょうか?

- A. SQL で JOIN 演算子を使用してテーブルを結合します。

- B. ネストされた WITH 文を使用してテーブルを結合します。

- C. SQL で UNION 演算子を使用してテーブルを結合します。

- D. SQL で UNION ALL 演算子を使用してテーブルを結合します。

Answer: C

Reference:

– SQL: UNION ALL Operator

Question 009

本番環境にデプロイされたアプリケーションがあります。

新しいバージョンがデプロイされると、アプリケーションが運用環境のユーザーからトラフィックを受信するまで、いくつかの問題は発生しません。影響と影響を受けるユーザーの数の両方を減らしたいと考えています。

どのデプロイメント戦略を使うべきでしょうか?

- A. Blue/Green デプロイ戦略

- B. カナリア テスト戦略

- C. ローリング アップデート デプロイ戦略

- D. 再作成 デプロイ戦略

Answer: B

Reference:

– GKE でのデプロイとテストの戦略の実装 | Cloud アーキテクチャ センター | Google Cloud

– アプリケーションのデプロイとテストの戦略 | Cloud アーキテクチャ センター | Google Cloud

– Six Strategies for Application Deployment – The New Stack

Question 010

会社は 人気のあるアプリケーションのユーザーを米国外に拡大したいと考えています。

アプリケーションのデータベースの 99.999% の可用性を確保し、世界中のユーザーの読み取り待ち時間を最小限に抑えたいと考えています。

どのアクションを実行する必要がありますか? (回答は 2つ)

- A. 「nam-eur-asia1」構成のマルチリージョンの Cloud Spanner インスタンスを作成します。

- B. 「nam3」構成でマルチリージョンの Cloud Spanner インスタンスを作成する。

- C. 少なくとも 3 つの Spanner ノードを持つクラスタを作成します。

- D. 少なくとも 1 つの Spanner ノードを持つクラスタを作成します。

- E. 少なくとも 1 つのノードを持つ別々のリージョンに、最低 2 つの Cloud Spanner インスタンスを作成します。

- F. 異なるデータベース間でデータを複製するために Cloud Dataflow パイプラインを作成します。

Answer: A、C

Question 011

500 MB のファイル サイズ制限が適用された内部ファイル アップロード API を App Engine に移行する必要があります。

何をするべきですか?

- A. FTP を使用してファイルをアップロードします。

- B. CPanel を使用してファイルをアップロードします。

- C. 署名付き URL を使用してファイルをアップロードします。

- D. API をマルチパート ファイル アップロード API に変更します。

Answer: C

Reference:

– Google Cloud Platform – Wikipedia

Question 012

アプリケーションを Google Kubernetes Engine (GKE) クラスタにデプロイする予定です。

アプリケーションは /healthz で HTTP ベースのヘルス チェックを公開します。このヘルス チェック エンドポイントを使用してロードバランサによってトラフィックを Pod にルーティングする必要があるかどうかを判断します。

Pod 構成に含める必要があるコード スニペットはどれでしょうか?

- A.

livenessProbe:

httpGet:

path: /healthz

port: 80 - B.

readinessProbe:

httpGet:

path: /healthz

port: 80 - C.

loadbalancerHealthCheck:

httpGet:

path: /healthz

port: 80 - D.

healthCheck:

httpGet:

path: /healthz

port: 80

Answer: B

GKE Ingress コントローラーが readinessProbes をヘルスチェックとして使用するためには Ingressの作成時に Ingress 用の Pod が存在する必要があります。レプリカが 0 にスケールされている場合、デフォルトのヘルスチェックが適用されます。

Question 013

チームメイトから次のコードを確認するように依頼されました。

BigQuery service = BigQueryOptions.newBuilder().build().getService();

public void writeToBigQuery (Collection<Map<String, String>> rows){

for (Map<String, String> row: rows) {

InsertAllRequest insertRequest = InsertAllRequest.newBuilder (

"datasetId", "tableId",

InsertAllRequest.RowToInsert. of (row)) .build();

service.insertAll (insertRequest);

}

}その目的は多数の小さな行を BigQuery テーブルに効率的に追加することです。

チームメイトにどのような改善を提案しますか?

- A. 各リクエストに複数の行を含めます。

- B. 複数のスレッドを作成し、挿入を並列に実行します。

- C. 各行を Cloud Storage オブジェクトに書き出し、BigQuery に読み込みます。

- D. 各行を並行して Cloud Storage オブジェクトに書き込み、BigQuery に読み込みます。

Answer: A

Question 014

Google Kubernetes Engine (GKE) でホストされる JPEG 画像リサイズ API を開発しています。

サービスの呼び出し元は同じ GKE クラスタ内に存在します。クライアントがサービスの IP アドレスを取得できるようにしたいと思います。

何をすべきでしょうか?

- A. GKE サービスを定義します。クライアントは Cloud DNS の A レコードの名前を使用してサービスのクラスタ IP アドレスを検索する必要があります。

- B. GKE サービスを定義します。クライアントは URL のサービス名を使用してサービスに接続する必要があります。

- C. GKE エンドポイントを定義します。クライアントはクライアント コンテナ内の適切な環境変数からエンドポイント名を取得する必要があります。

- D. GKE エンドポイントを定義します。クライアントは Cloud DNS からエンドポイント名を取得する必要があります。

Answer: B

Question 015

Cloud Build を使用して Cloud Source Repositories に保存されているアプリケーション ソースコードをビルドおよびテストしています。

ビルド プロセスには Cloud Build 環境では使用できないビルド ツールが必要です。

何をするべきでしょうか?

- A. ビルド中にインターネットからバイナリをダウンロードします。

- B. カスタム クラウドビルダーイメージを構築し、ビルド手順の中でそのイメージを参照します。

- C. バイナリを Cloud Source Repositories のリポジトリに含め、ビルドスクリプトで参照します。

- D. Cloud Build パブリック問題追跡システムに機能リクエストを提出し、Cloud Build 環境にバイナリを追加するよう依頼します。

Answer: B

Question 016

Compute Engine の仮想マシンインスタンスにアプリケーションをデプロイしています。

アプリケーションはログファイルをディスクに書き込むように構成されています。アプリケーションコードを変更せずにStackdriver Loggingでログを表示したいと考えています。

何をするべきでしょうか?

- A. Stackdriver Logging エージェントをインストールし、アプリケーション ログを送信するように構成します。

- B. Stackdriver Logging ライブラリを使用し、アプリケーションから Stackdriver Logging に直接ログを記録します。

- C. インスタンスのメタ データにログ ファイル フォルダ パスを指定し、アプリケーション ログを送信するように構成します。

- D. ログが Stackdriver Logging に自動的に送信されるように、/var/log にログを記録するようにアプリケーションを変更します。

Answer: A

Question 017

サービスは Cloud Storage から読み込んだ画像にテキストを追加します。

混雑する時期には Cloud Storage へのリクエストは HTTP 429 の「Too Many Requests」ステータスコードで失敗します。

このエラーはどのように処理すればよいでしょうか?

- A. オブジェクトに cache-control ヘッダーを追加します。

- B. Google Cloud Console から割り当ての増加をリクエストします。

- C. 切り捨てられた指数バックオフ戦略でリクエストを再試行します。

- D. Cloud Storage バケットのストレージ クラスをマルチリージョンに変更します。

Answer: C

Reference:

– 使用量上限 | Gmail | Google Developers

Question 018

Android / iOS アプリで使用される API を構築しています。

API は次のことを行う必要があります。

– HTTPs をサポート

– 帯域幅のコストを最小限に抑える

– モバイルアプリと簡単に統合

どの API アーキテクチャを使用しますか?

- A. RESTful APIs

- B. MQTT for APIs

- C. gRPC-based APIs

- D. SOAP-based APIs

Answer: C

Reference:

– How to Build a REST API for Mobile App? – DevTeam.Space

Question 019

アプリケーションはユーザーからの入力を受け取り、それをユーザーの連絡先に公開します。

この入力は Cloud Spanner のテーブルに保存されます。アプリケーションはレイテンシーに対してより敏感であり、一貫性に対してより敏感ではありません。

このアプリケーションの Cloud Spanner からの読み取りをどのように実行する必要がありますか?

- A. 読み取り専用トランザクションを実行します。

- B. 単一読み取り方式を使用して古い読み取りを実行します。

- C. 単一読み取り方法を使用して強力な読み取りを実行します。

- D. 読み書きトランザクションを使用して古い読み取りを実行します。

Answer: B

Reference:

– ゲーム データベースとして Cloud Spanner を使用する場合のベスト プラクティス | Cloud アーキテクチャ センター | Google Cloud

Question 020

アプリケーションは Google Kubernetes Engine (GKE) クラスタにデプロイされています。

アプリケーションの新しいバージョンがリリースされると CI / CD ツールはspec.template.spec.containers[0].image 値を更新して新しいアプリケーション バージョンの Docker イメージを参照します。Deployment オブジェクトが変更を適用するとき、新しいバージョンの少なくとも 1 つのレプリカをデプロイし、新しいレプリカが健全になるまで以前のレプリカを維持したいと思います。

以下に示す GKE Deployment オブジェクトにどのような変更を加えるべきですか?

apiVersion: apps/v1

kind: Deployment

metadata:

name: ecommerce-frontend-deployme

spec:

replicas: 3

selector:

matchLabels:

app: ecommerce-frontend

template:

metadata:

labels:

app: ecommerce-frontend

spec:

containers

name: ecommerce-frontend-webapp

image: ecommerce-frontend-webapp:1.7.9

ports:

containerPort: 80- A. デプロイメント戦略を RollingUpdate に設定し、maxSurge を 0 に、maxUnavailable を 1 に設定する。

- B. デプロイメント戦略を RollingUpdate に設定し、maxSurge を 1、maxUnavailable を 0 に設定します。

- C. デプロイメント戦略を Recreate に設定し、maxSurge を 0 に、maxUnavailable を 1 に設定します。

- D. デプロイメント戦略を Recreate に設定し、maxSurge を 1、maxUnavailable を 0 に設定します。

Answer: B

Question 021

簡単な HTML アプリケーションをインターネット上で公開することを計画しています。

このサイトにはアプリケーションの FAQ に関する情報が保存されています。アプリケーションは静的で画像、HTML、CSS、Javascript が含まれています。できるだけ少ない手順でこのアプリケーションをインターネット上で利用できるようにしたいと考えています。

どうすればいいでしょうか?

- A. アプリケーションを Cloud Storage にアップロードします。

- B. App Engine 環境にアプリケーションをアップロードする。

- C. Apache Web サーバがインストールされた Compute Engine インスタンスを作成します。アプリケーションをホストする Apache Web サーバを設定します。

- D. 最初にアプリケーションをコンテナ化します。このコンテナを Google Kubernetes Engine (GKE) にデプロイし、アプリケーションをホストする GKE Pod に外部 IP アドレスを割り当てます。

Answer: A

Reference:

– 静的ウェブサイトをホストする | Cloud Storage | Google Cloud

Question 022

会社は新しい API を App Engine スタンダード環境にデプロイしました。

テスト中に API が期待どおりに動作しませんでした。アプリケーションを再デプロイせず、アプリケーション コード内の問題を診断するために長期にわたってアプリケーションを監視する必要があります。

どのツールを使用するべきでしょうか?

- A. Stackdriver Trace

- B. Stackdriver Monitoring

- C. Stackdriver Debug Snapshots

- D. Stackdriver Debug Logpoints

Answer: D

Reference:

– GCP Stackdriver Tutorial : Debug Snapshots, Traces, Logging and Logpoints | by Romin Irani

Question 023

Stackdriver Logging エージェントを使用し、Compute Engine 仮想マシンインスタンスから Stackdriver にアプリケーションのログファイルを送信したいと思います。

Stackdriver Logging エージェントをインストールした後、最初に何をするべきでしょうか?

- A. プロジェクトで Error Reporting API を有効化します。

- B. インスタンスすべての Cloud API へのフルアクセスを許可します。

- C. アプリケーションのログ ファイルをカスタムソースとして構成する。

- D. アプリケーションのログ エントリに一致するフィルタを持つ Stackdriver Logs シンクのエクスポートを作成します。

Answer: C

Question 024

会社には数百人の従業員に分析情報を提供する BigQuery データマートがあります。

とあるユーザーは重要なワークロードを中断することなくジョブを実行したいと考えています。このユーザーはこれらのジョブの実行にかかる時間については気にしていません。会社のコストと自分の労力を最小限に抑えながら、この要求を満たしたいと考えています。

どうすればいいのでしょうか?

- A. ジョブをバッチ ジョブとして実行するようユーザーに依頼します。

- B. ユーザーがジョブを実行するための別のプロジェクトを作成します。

- C. 既存のプロジェクトにユーザーを job.user ロールとして追加します。

- D. 重要なワークロードが実行されていないときにユーザーがジョブを実行できるようにします。

Answer: A

Question 025

開発時間を最小限に抑えながら、本番環境でのサービスの低下についてオンコール エンジニアに通知したいと考えています。

どうするべきでしょうか?

- A. Cloud Functions を使用してリソースを監視し、アラートを生成します。

- B. Cloud Pub/Sub を使用してリソースを監視し、アラートを生成します。

- C. Stackdriver Error Reporting を使用してエラーをキャプチャし、アラートを生成します。

- D. Stackdriver Monitoring を使用してリソースを監視し、アラートを生成します。

Answer: D

Question 026

XMLHttpRequest を使用してコンテンツのためにサードパーティ API と通信するユーザー インターフェース (UI) を持つ単一ページの Web アプリケーションを作成しています。

API の結果によって UI に表示されるデータは同じ Web ページに表示される他のデータよりも重要度が低いため、リクエストによっては API のデータが UI に表示されないことも許容されます。しかし、API への呼び出しによってユーザー インターフェースの他の部分のレンダリングが遅れることがあってはなりません。API レスポンスがエラーやタイムアウトの場合でもアプリケーションのパフォーマンスを向上させたいと考えています。

どうすればいいのでしょうか?

- A. API へのリクエストの非同期オプションを false に設定し、タイムアウトまたはエラーが発生したときに API の結果を表示するウィジェットを省略します。

- B. API へのリクエストの非同期オプションを true に設定し、タイムアウトまたはエラーが発生したときに API の結果を表示するウィジェットを省略します。

- C. API 呼び出しからタイムアウトまたはエラー例外をキャッチし、API レスポンスが成功するまで指数バックオフを試行し続けます。

- D. API 呼び出しからタイムアウトまたはエラー例外をキャッチし、UI ウィジェットにエラーレスポンスを表示します。

Answer: B

Question 027

Compute Engine インスタンスで実行し、任意のユーザーの Google ドライブにファイルを書き込む Web アプリケーションを作成しています。

Google ドライブ API に認証するためにアプリケーションを構成する必要があります。

どうすればいいでしょうか?

- A. https://www.googleapis.com/auth/drive.file スコープを使用する OAuth クライアント ID を使用し、各ユーザーのアクセストークンを取得します。

- B. ドメイン全体の権限を委譲された OAuth クライアント ID を使用します。

- C. App Engine サービスアカウントと https://www.googleapis.com/auth/drive.file スコープを使用し、署名付き JSON Web Token (JWT) を生成します。

- D. ドメイン全体の権限を委譲された App Engine のサービスアカウントを使用します。

Answer: A

Reference:

– API 固有の承認および認証情報 | Google Drive | Google Developers

Question 028

Google Kubernetes Engine (GKE) クラスタを作成し、次のコマンドを実行します。

> gcloud container clusters create large-cluster --num-nodes 200コマンドは次のエラーで失敗します。

insufficient regional quota to satisfy request: resource “CPUS”: request requires ‘200.0’ and is short ‘176.0’ project has quota of ‘24.0’ with ‘24.0’ availableこのエラー問題を解決するために何をするべきでしょうか?

- A. Google Cloud Console で追加の GKE 割り当てをリクエストします。

- B. Google Cloud Console で追加の Compute Engine 割り当てをリクエストします。

- C. サポート ケースを開いて、追加の GKE 割り当てをリクエストする。

- D. クラスタ内のサービスを分離し、より少ないコア数で機能するように新しいクラスタを書き換えます。

Answer: B

Question 029

タイムスタンプ、口座番号 (文字列)、取引金額 (数値) という 3 つの列を含むログ ファイルを解析しています。

一意の口座番号ごとにすべての取引金額の合計を効率的に計算したいと考えています。

どのデータ構造を使うべきでしょうか?

- A. リンクされたリスト

- B. ハッシュテーブル

- C. 2 次元配列

- D. コンマ区切りの文字列

Answer: B

Question 030

会社には従業員の出張や経費に関する情報を保持する「Master」という名前の BigQuery データセットがあります。

このデータセットは従業員の部署ごとに整理されています。つまり、従業員は自分の部門の情報のみを表示できる必要があります。セキュリティ フレームワークを適用して最小限の手順でこの要件を適用したいと考えています。

どうすればいいでしょうか?

- A. 部門ごとに個別のデータセットを作成します。特定の部門の特定のデータセットからレコードを選択するには適切な WHERE 句を使用してビューを作成します。マスター データセットのレコードにアクセスするには、このビューを承認してください。この部門固有のデータセットに対する権限を従業員に付与します。

- B. 部門ごとに個別のデータセットを作成します。部門ごとにデータ パイプラインを作成して、マスター データセットから部門の特定のデータセットに適切な情報をコピーします。この部門固有のデータセットに対する権限を従業員に付与します。

- C. マスター データセットという名前のデータセットを作成します。マスター データセットの部門ごとに個別のビューを作成します。部門の特定のビューへのアクセス権を従業員に付与します。

- D. マスター データセットという名前のデータセットを作成します。マスター データセットの部門ごとに個別のテーブルを作成します。部門の特定のテーブルへのアクセス権を従業員に付与します。

Answer: C

Question 031

実稼働中のアプリケーションがあります。

これはマネージド インスタンス グループによって制御される Compute Engine 仮想マシン インスタンスにデプロイされます。トラフィックは HTTP (S) ロードバランサを介してインスタンスにルーティングされ、ユーザーはアプリケーションにアクセスできません。アプリケーションが利用できない場合に警告する監視手法を実装したいと考えています。

どの技術を選択するべきでしょうか?

- A. スモークテスト

- B. Stackdriver の稼働時間チェック

- C. Cloud Load Balancing – ヘルスチェック

- D. マネージド インスタンス グループ – ヘルス チェック

Answer: B

Reference:

– Stackdriver Monitoring Automation Part 3: Uptime Checks | by Charles | Google Cloud – Community | Medium

Question 032

サーバ アプリケーションの負荷テストを行っています。

最初の 30 秒間で以前はアクティブでなかった Cloud Storage バケットが 2,000 件/秒の書き込みリクエストと 7,500 件/秒の読み取りリクエストに対応していることを確認しました。リクエストが増大するにつれて、アプリケーションは Cloud Storage JSON API から断続的に 5xx と 429 の HTTP レスポンスを受け取るようになりました。Cloud Storage API からの失敗した応答を減少させたいと考えています。

どうすればよいでしょうか?

- A. 多数の個々の Cloud Storage バケットにアップロードを分散します。

- B. Cloud Storage とのインターフェースに JSON API の代わりに XML API を使用します。

- C. アプリケーションからアップロードを呼び出しているクライアントに HTTP レスポンスコードを返します。

- D. アプリケーション クライアントからのアップロード速度を制限し、休止中のバケットのピーク リクエスト レートに徐々に到達するようにします。

Answer: D

Reference:

– リクエスト レートとアクセス配信のガイドライン | Cloud Storage | Google Cloud

Question 033

アプリケーションはマネージド インスタンス グループによって制御されます。

マネージド インスタンス グループ内のすべてのインスタンス間で大規模な読み取り専用データセットを共有したいと考えています。各インスタンスが迅速に起動し、ファイル システムを介して非常に低いレイテンシーでデータセットにアクセスできるようにする必要があります。またソリューションの総コストを最小限に抑えたいと考えています。

どうすればいいでしょうか?

- A. データを Cloud Storage バケットに移動し、Cloud Storage FUSE を使用してバケットをファイル システムにマウントします。

- B. データを Cloud Storage バケットに移動し、起動スクリプトを使用してデータをインスタンスのブートディスクにコピーします。

- C. データを Compute Engine 永続ディスクに移動してそのディスクを読み取り専用モードで複数の Compute Engine 仮想マシン インスタンスに接続します。

- D. データを Compute Engine の永続ディスクに移動してスナップショットを作成し、スナップショットから複数のディスクを作成して各ディスクを独自のインスタンスに接続します。

Answer: C

Question 034

同じ Virtual Private Cloud (VPC) 内の複数のクライアントから呼び出される必要がある Compute Engine 仮想マシンインスタンス上でホストされる HTTP API を開発しています。

クライアントがサービスの IP アドレスを取得できるようにしたいです。

どうすればいいでしょうか?

- A. 静的な外部 IP アドレスを確保し、HTTP(S) ロードバランサ サービスの転送ルールに割り当てます。クライアントはこの IP アドレスを使用してサービスに接続する必要があります。

- B. 静的な外部 IP アドレスを確保し、HTTP(S) ロードバランサ サービスの転送ルールに割り当てる。その後、Cloud DNS で A レコードを定義します。クライアントは A レコードの名前を使用してサービスに接続する必要があります。

- C. https://[INSTANCE_NAME].[ZONE].c.[PROJECT_ID].internal/ という URL でインスタンス名に接続し、クライアントが Compute Engine 内部 DNS を使用することを確認します。

- D. クライアントが https://[API_NAME]/[API_VERSION]/ の URL でインスタンス名に接続することによって Compute Engine の内部 DNS を使用することを確認します。

Answer: C

Question 035

アプリケーションは Stackdriver にログを記録しています。

すべての /api/alpha/* エンドポイントですべてのリクエストの数を取得したいと考えています。

どうすればいいでしょうか?

- A. path:/api/alpha/ の Stackdriver カウンタ指標を追加します。

- B. エンドポイント: /api/alpha/* の Stackdriver カウンタ指標を追加します。

- C. ログを Cloud Storage にエクスポートし、/api/alpha に一致する行をカウントします。

- D. ログを Cloud Pub/Sub にエクスポートし、/api/alpha に一致する行をカウントします。

Answer: B

Question 036

マイクロサービス モデルに従うようにモノリシック アプリケーションを再構築したいと考えています。

この変更がビジネスに与える影響を最小限に抑えながら効率的に達成したいと考えています。

どのアプローチを取るべきでしょうか?

- A. アプリケーションを Compute Engine にデプロイし、自動スケーリングを有効にします。

- B. アプリケーションの機能を段階的に適切なマイクロサービスに置き換えます。

- C. 単一の作業で適切なマイクロサービスを使用してモノリシック アプリケーションをリファクタリングし、デプロイします。

- D. モノリスとは別の適切なマイクロサービスを使用して新しいアプリケーションを構築し、完成したら置き換えます。

Answer: B

Reference:

– モノリシック アプリケーションを Google Kubernetes Engine のマイクロサービスに移行する | Google Cloud への移行

Question 037

既存のアプリケーションはユーザー状態情報を単一の MySQL データベースに保持します。

この状態情報はユーザー固有であり、ユーザーがアプリケーションを使用している時間に大きく依存します。MySQL データベースはさまざまなユーザーのスキーマを維持および強化するという課題を引き起こしています。

どのストレージ オプションを選択すべきでしょうか?

- A. Cloud SQL

- B. Cloud Storage

- C. Cloud Spanner

- D. Cloud Datastore / Cloud Firestore

Answer: D

Reference:

– Database Migration Service | Google Cloud

Question 038

新しい API を構築しています。

画像の保存コストを最小限に抑え、画像提供の待ち時間を短縮したいと考えています。

どのアーキテクチャを使うべきでしょうか?

- A. Cloud Storage を基盤とする App Engine

- B. 永続ディスクに支えられた Compute Engine

- C. Cloud Filestore がサポートする Transfer Appliance

- D. Cloud Storage を基盤とする Cloud Content Delivery Network (CDN)

Answer: D

Question 039

開発チームはプロジェクトで Cloud Build を使用して Docker イメージを構築し、Container Registry にプッシュしたいと考えています。

運用チームが管理する一元化された安全に管理された Docker レジストリにすべての Docker イメージを公開する必要があります。

何をするべきでしょうか?

- A. Container Registry を使用し、各開発チームのプロジェクトにレジストリを作成します。Cloud Build ビルドを構成し、Docker イメージをプロジェクトのレジストリにプッシュします。各開発チームのレジストリへのアクセス権を運用チームに付与します。

- B. Container Registry が構成されている運用チーム用に別のプロジェクトを作成します。各デベロッパー チームのプロジェクトの Cloud Build サービス アカウントに適切な権限を割り当て、運用チームのレジストリへのアクセスを許可します。

- C. Container Registry が構成されている運用チーム用に別のプロジェクトを作成します。開発チームごとにサービス アカウントを作成して適切なアクセス許可を割り当て、運用チームのレジストリにアクセスできるようにします。サービス アカウント キー ファイルをソース コード リポジトリに保存し、運用チームのレジストリに対して認証するために使用します。

- D. Compute Engine 仮想マシン インスタンスにオープン ソースの Docker レジストリをデプロイする運用チーム用の別のプロジェクトを作成します。各開発チームのユーザー名とパスワードを作成します。ユーザー名とパスワードをソース コード リポジトリに保存し、運用チームの Docker レジストリに対して認証するために使用します。

Answer: B

Reference:

– Container Registry | Google Cloud

Question 040

アプリケーションを Google Kubernetes Engine (GKE) クラスタにデプロイする予定です。

アプリケーションは水平方向にスケーリングでき、アプリケーションの各インスタンスには安定したネットワーク ID と独自の永続ディスクが必要です。

どの GKE オブジェクトを使用するべきでしょうか?

- A. Deployment

- B. StatefulSet

- C. ReplicaSet

- D. ReplicaController

Answer: B

Reference:

– Chapter 10. StatefulSets: deploying replicated stateful applications – Kubernetes in Action

Question 041

Cloud Build を使用して Docker イメージを構築しています。

ビルドを変更してユニットを実行し、統合テストを実行する必要があります。障害が発生した場合、ビルド履歴にビルドが失敗した段階を明確に表示させたいと考えています。

どうすればいいでしょうか?

- A. Dockerfile に RUN コマンドを追加し、ユニットテストと統合テストを実行します。

- B. ユニットテストと統合テストをコンパイルするための単一のビルドステップを持つ Cloud Build ビルド設定ファイルを作成する。

- C. ユニットテストと統合テストのために別の Cloud Build パイプラインを生成する Cloud Build ビルド設定ファイルを作成します。

- D. ユニットテストと統合テストをコンパイルして実行するための別々の Cloud Build ステップを持つ Cloud Build ビルド構成ファイルを作成します。

Answer: D

Question 042

コードはプロジェクト A の Cloud Functions で実行されています。

プロジェクト B が所有する Cloud Storage バケットにオブジェクトを書き込むことになっていますが、書き込み呼び出しが「403 Forbidden」というエラーで失敗しています。

問題を解決するにはどうすればよいですか?

- A. ユーザーアカウントに Cloud Storage バケットの roles/storage.objectCreator のロールを付与します。

- B. ユーザーアカウントに service-PROJECTA@gcf-admin-robot.iam.gserviceaccount.com サービスアカウント用の roles/iam.serviceAccountUser のロールを付与します。

- C. service-PROJECTA@gcf-admin-robot.iam.gserviceaccount.com サービスアカウントに Cloud Storage バケットの roles/storage.objectCreator のロールを付与します。

- D. プロジェクト B で Cloud Storage API を有効化します。

Answer: C

Question 043

この問題は HipLocal のケーススタディを参照してください。

HipLocal の .net ベースの認証サービスは断続的な負荷で失敗します。

どうすればいいでしょうか?

- A. 自動スケーリングに App Engine を使用します。

- B. 自動スケーリングに Cloud Functions を使用します。

- C. サービスに Compute Engine クラスタを使用します。

- D. サービスに Compute Engine 仮想マシン インスタンスを使用します。

Answer: C

Reference:

– Autoscaling an Instance Group with Custom Cloud Monitoring Metrics

Question 044

この問題は HipLocal のケーススタディを参照してください。

HipLocal の API では時折アプリケーションに障害が発生しています。

この問題のトラブルシューティングのためにアプリケーション情報を特別に収集したいと考えています。

どうすればいいでしょうか?

- A. 仮想マシンのスナップショットを頻繁に作成します。

- B. Cloud Logging エージェントを仮想マシンにインストールします。

- C. Cloud Monitoring エージェントを仮想マシンにインストールします。

- D. Cloud Trace を使用してパフォーマンスのボトルネックを探します。

Answer: B

Question 045

この問題は HipLocal のケーススタディを参照してください。

HipLocal は永続ディスクに保存されたデータを照会するために Cloud Interconnect を使用して Hadoop インフラを GCP に接続しています。

どの IP 戦略を使うべきでしょうか?

- A. 手動でサブネットを作成します。

- B. オートモード サブネットを作成します。

- C. 複数のピアリング VPC を作成します。

- D. NAT 用に単一のインスタンスをプロビジョニングします。

Answer: A

Question 046

この問題は HipLocal のケーススタディを参照してください。

社内アプリへのアクセスを可能にするために HipLocal はどのサービスを利用すべきでしょうか?

- A. Cloud VPN

- B. Cloud Armor

- C. Virtual Private Cloud

- D. Cloud Identity-Aware Proxy

Answer: D

Reference:

– オンプレミス アプリの IAP の概要 | Identity-Aware Proxy | Google Cloud

Question 047

この問題は HipLocal のケーススタディを参照してください。

HipLocal はオンコールエンジニアの数を減らし、手作業によるスケーリングをなくしたいと考えています。

どのサービスを選択するべきでしょうか?(回答は 2 つ)

- A. Google App Engine サービスを使用します。

- B. サーバレスの Google Cloud Functions を使用します。

- C. Knative を使用してサーバレス アプリケーションを構築およびデプロイします。

- D. 自動デプロイに Google Kubernetes Engine を使用します。

- E. デプロイには大規模な Google Compute Engine クラスタを使用します。

Answer: C、D

Question 048

この問題は HipLocal のケーススタディを参照してください。

ビジネス要件を満たすために HipLocal はアプリケーションの状態をどのように保存する必要がありますか?

- A. ローカル SSD を使用してステートを保存します。

- B. MySQLの前に Memcached レイヤーを配置します。

- C. ステート ストレージを Cloud Spanner に移行します。

- D. MySQL インスタンスを Cloud SQL に置き換えます。

Answer: D

Question 049

この問題は HipLocal のケーススタディを参照してください。

HipLocal がパブリック API に使用する必要があるサービスはどれですか?

- A. Cloud Armor

- B. Cloud Functions

- C. Cloud Endpoints

- D. Shielded Virtual Machines

Answer: C

Question 050

この問題は HipLocal のケーススタディを参照してください。

HipLocal はビジネスと技術的な要件を満たしつつ、MySQL の耐障害性を向上させたいと考えています。

どのような構成を選択すればよいのでしょうか?

- A. Compute Engine の現在のシングル インスタンス MySQL と Compute Engine の複数の読み取り専用 MySQL サーバを使用します。

- B. Compute Engine で現在のシングル インスタンス MySQL を使用し、外部マスター構成で Cloud SQL にデータをレプリケートする。

- C. 現在のシングル インスタンスの MySQL インスタンスを Cloud SQL に置き換え、高可用性を構成します。

- D. 現在のシングル インスタンスの MySQL インスタンスを Cloud SQL に置き換えると、Google は追加の構成なしで冗長性を提供します。

Answer: C

Question 051

アプリケーションは複数の Google Kubernetes Engine クラスタで動作しています。

これらは各クラスタの Deployment によって管理され、各クラスタに Pod の複数のレプリカが作成されています。すべてのクラスタの Deployment のすべてのレプリカの stdout に送信されたログを表示したいと思います。

どのコマンドを使用するべきでしょうか?

- A. kubectl logs [PARAM]

- B. gcloud logging read [PARAM]

- C. kubectl exec “it [PARAM] journalctl

- D. gcloud compute ssh [PARAM] “-command= sudo journalctl

Answer: B

Question 052

Cloud Build を使用して Cloud Source Repositories リポジトリにコミットされた各ソースコードに新しい Docker イメージを作成しています。

アプリケーションはマスター ブランチへのコミットごとに構築されます。マスター ブランチに対して行われた特定のコミットを自動化された方法でリリースしたいと考えています。

何をするべきでしょうか?

- A. 新しいリリースのビルドを手動でトリガーします。

- B. Git タグ パターンでビルド トリガーを作成します。新しいリリースには Git タグ規則を使用します。

- C. Git ブランチ名パターンでビルド トリガーを作成します。新しいリリースには Git ブランチの命名規則を使用します。

- D. 2つ目の Cloud Build トリガーを使用し、ソースコードを 2 番目の Cloud Source Repositories リポジトリにコミットします。このリポジトリは新規リリースにのみ使用します。

Answer: B

Reference:

– Set up Automated Builds

Question 053

MySQL から Cloud Bigtable に移行されるテーブルのスキーマを設計しています。

MySQL のテーブルは以下の通りです。

AccountActivity

(

Account id int,

Event_timestamp datetime,

Transction_type string,

Amount numeric(18, 4)

) primary key (Account_id, Event_timestamp)このテーブルの Cloud Bigtable の行キーはどのように設計すればよいのでしょうか?

- A. Set Account_id as a key.

- B. Set Account_id_Event_timestamp as a key.

- C. Set Event_timestamp_Account_id as a key.

- D. Set Event_timestamp as a key.

Answer: B

Question 054

Compute Engine にデプロイされたアプリケーションのメモリ使用量を表示したいです。

どうすればいいでしょうか?

- A. Stackdriver クライアント ライブラリをインストールします。

- B. Stackdriver Monitoring エージェントをインストールします。

- C. Stackdriver Metrics Explorer を使用します。

- D. Google Cloud Consoleを使用します。

Answer: B

Reference:

– Google Cloud Platform: how to monitor memory usage of VM instances – Stack Overflow

Question 055

BigQuery API を使用し、数分ごとに BigQuery で数百のクエリを実行する分析アプリケーションがあります。

これらのクエリの実行にかかる時間を調べたいと考えています。

どうすればいいでしょうか?

- A. Stackdriver Monitoring を使用し、スロットの使用状況をプロットします。

- B. Stackdriver Trace を使用し、API 実行時間をプロットします。

- C. Stackdriver Trace を使用し、クエリ実行時間をプロットします。

- D. クエリ実行時間をプロットするために Stackdriver Monitoring を使用します。

Answer: D

Question 056

Cloud Spanner 顧客データベースのスキーマを設計しています。

電話番号配列フィールドを顧客テーブルに格納します。またユーザーが電話番号で顧客を検索できるようにします。

このスキーマをどのように設計するべきでしょうか?

- A. Customers という名前のテーブルを作成します。顧客の電話番号を保持するテーブルの Array フィールドを追加する。

- B. Customers という名前のテーブルを作成します。Phones という名前のテーブルを作成します。電話番号から CustomerId を見つけるために Phones テーブルに CustomerId フィールドを追加します。

- C. Customers という名前のテーブルを作成します。顧客の電話番号を保持するテーブル内にArrayフィールドを追加する。Array フィールドにセカンダリ インデックスを作成します。

- D. 親テーブルとして Customers という名前のテーブルを作成します。Phones という名前のテーブルを作成し、このテーブルを Customer テーブルにインターリーブします。Phones テーブルの電話番号フィールドにインデックスを作成します。

Answer: D

Question 057

http://www.altostrat.com/ の URL 経由でアクセスできるようにする必要がある App Engine に単一の Web サイトをデプロイしています。

どうすればいいでしょうか?

- A. Google 検索セントラルでドメインの所有権を確認します。App Engine の正規名 ghs.googlehosted.com を指す DNS CNAME レコードを作成します。

- B. Google 検索セントラルでドメインの所有権を確認します。単一のグローバル App Engine IP アドレスを指す A レコードを定義します。

- C. dispatch.yaml でマッピングを定義し、ドメイン www.altostrat.com を App Engine サービスに向けます。App Engine の正規名 ghs.googlehosted.com を指す DNS CNAME レコードを作成します。

- D. dispatch.yaml でマッピングを定義し、ドメイン www.altostrat.com を App Engine サービスに向けます。単一のグローバル App Engine IP アドレスを指す A レコードを定義します。

Answer: A

Reference:

– カスタム ドメインのマッピング | .NET の App Engine フレキシブル環境に関するドキュメント | Google Cloud

Question 058

継承した App Engine でアプリケーションを実行しています。

アプリケーションが安全でないバイナリを使用しているかどうか、または XSS 攻撃に対して脆弱であるかどうかを確認したいと考えています。

どうすればいいでしょうか?

- A. Cloud Amor

- B. Stackdriver Debugger

- C. Cloud Security Scanner

- D. Stackdriver Error Reporting

Answer: C

Reference:

– Security Command Center | Google Cloud

Question 059

ソーシャル メディア アプリケーションに取り組んでいます。

ユーザーが画像をアップロードできる機能を追加することを計画しています。これらの画像は 2 MB ~ 1 GB のサイズになります。この機能のためのインフラ運用のオーバーヘッドを最小限に抑えたいと考えています。

どうすればいいでしょうか?

- A. アプリケーションを変更して画像を直接受け取り、他のユーザー情報を保存するデータベースに保存します。

- B. Cloud Storage の署名付き URL を作成するようにアプリケーションを変更します。これらの署名付き URL をクライアント アプリケーションに転送し、画像を Cloud Storage にアップロードします。

- C. ユーザーの画像を受け入れるように GCP に Web サーバをセットアップし、アップロードされたファイルを保持するファイル ストアを作成します。ファイル ストアから画像を取得するようにアプリケーションを変更します。

- D. Cloud Storage でユーザーごとに個別のバケットを作成します。各バケットへの書き込みアクセスを許可する個別のサービス アカウントを割り当てます。ユーザー情報に基づいて、サービス アカウント資格情報をクライアント アプリケーションに転送します。アプリケーションはこのサービス アカウントを使用し、画像を Cloud Storage にアップロードします。

Answer: B

Reference:

– 署名付き URL を活用して Cloud Storage に画像ファイルを直接アップロードするアーキテクチャを設計する | Google Cloud 公式ブログ

Question 060

アプリケーションはカスタム マシン イメージとしてビルドされます。

マシン イメージの複数の固有のデプロイメントがあります。各デプロイは独自のテンプレートを持つ別のマネージド インスタンス グループです。各デプロイメントには固有の設定値のセットが必要です。これらの固有の値を各配備に提供しますが、すべてのデプロイで同じカスタム マシン イメージを使用する必要があります。Compute Engine ですぐに使える機能を使用したいと思っています。

どうすればいいでしょうか?

- A. 固有の構成値を永続ディスクに配置します。

- B. Cloud Bigtable テーブルに一意の構成値を配置します。

- C. インスタンス テンプレートの起動スクリプトに一意の構成値を配置します。

- D. インスタンス テンプレートのインスタンス メタデータに一意の構成値を配置します。

Answer: D

Reference:

– インスタンス グループ | Compute Engine ドキュメント | Google Cloud

Question 061

ローカルでテストした場合、アプリケーションのパフォーマンスは良好ですが Compute Engine インスタンスにデプロイすると実行速度が大幅に低下します。

問題を診断する必要があります。

何をするべきでしょうか?

- A. Google Cloud サポートにチケットを提出し、アプリケーションがローカルでより高速に実行されることを示します。

- B. Cloud Debugger のスナップショットを使用し、アプリケーションの特定時点の実行を確認します。

- C. Cloud Profiler を使用し、アプリケーション内のどの機能に最も時間がかかっているかを判断します。

- D. Logging コマンドをアプリケーションに追加し、Cloud Logging を使用してレイテンシー問題が発生する場所を確認します。

Answer: C

Question 062

App Engineでアプリケーションを実行しています。

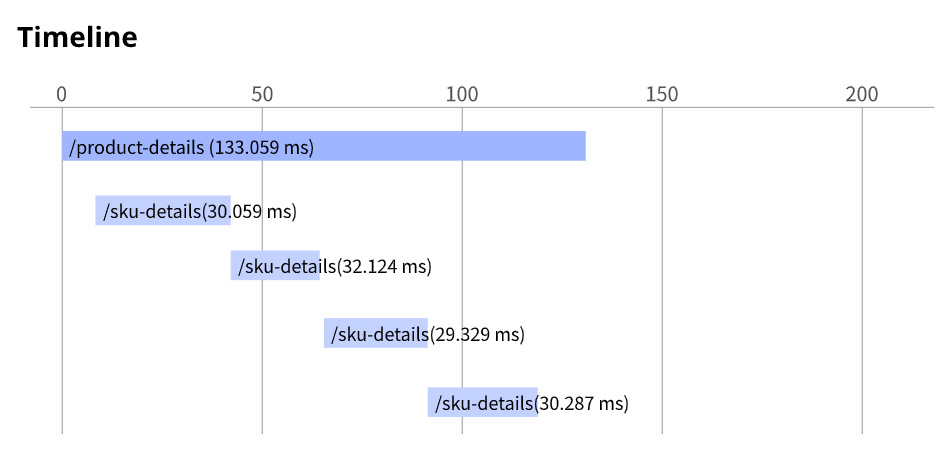

アプリケーションは Stackdriver Trace で計装されています。/product-details リクエストは次の図のように /sku-details にある 4 つの既知の固有の製品に関する詳細をレポートします。リクエストが完了するまでの時間を短縮したいと思います。

どうすればいいでしょうか?

- A. インスタンス クラスのサイズを増やします。

- B. 永続ディスクのタイプを SSD に変更します。

- C. /product-details を変更し、リクエストを並行して実行します。

- D. /sku-details 情報をデータベースに保存し、Web サービス呼び出しをデータベース クエリに置き換えます。

Answer: C

Question 063

会社にはアプリケーション情報を BigQuery に保持するデータ ウェアハウスがあります。

BigQuery データ ウェアハウスは 2 PB のユーザー データを保持します。最近、会社は EU ユーザーを含むようにユーザー ベースを拡大し、次の要件に準拠する必要があります。

– 会社はユーザーの要求に応じてすべてのユーザー アカウント情報を削除する必要があります。

– すべての EU ユーザー データは EU ユーザー専用の 1 つのリージョンに保存する必要があります。

どのようなアクションを実行するべきでしょうか?(回答は 2 つ)

- A. BigQuery 連携クエリを使用し、Cloud Storage からデータをクエリします。

- B. EU ユーザーに関する情報のみを保持する EU 地域でデータセットを作成します。

- C. EU ユーザーのみの情報を保存するために EU リージョンに Cloud Storage バケットを作成します。

- D. ユーザー レコードを除外し、Cloud Dataflow パイプラインを使用してデータを再アップロードします。

- E. BigQuery で DML ステートメントを使用し、リクエストに基づいてユーザー レコードを更新または削除します。

Answer: B、E

Reference:

– BigQuery とは | Google Cloud

Question 064

Google App Engine スタンダード環境は次のとおりです。

– service: production

– instance_class: B1

アプリケーションを 5 つのインスタンスに制限したいと考えています。

構成に含める必要があるコード スニペットはどれでしょうか?

- A. manual_scaling: instances: 5 min_pending_latency: 30ms

- B. manual_scaling: max_instances: 5 idle_timeout: 10m

- C. basic_scaling: instances: 5 min_pending_latency: 30ms

- D. basic_scaling: max_instances: 5 idle_timeout: 10m

Answer: D

Question 065

分析システムは BigQuery データセットに対してクエリを実行します。

SQL クエリはバッチで実行され、SQL ファイルの内容を BigQuery CLI に渡します。次に BigQuery CLI 出力を別のプロセスにリダイレクトしますが、クエリの実行時に BigQuery CLI からパーミッション エラーが発生しているため、この問題を解決したいと考えています。

何をするべきでしょうか?

- A. サービス アカウントに BigQuery データ閲覧者と BigQuery ジョブ ユーザーのロールを付与します。

- B. サービス アカウントに BigQuery データ編集者と BigQuery データ閲覧者の役割を付与します。

- C. SQL クエリから BigQuery でビューを作成し、CLI でビューから SELECT* を作成します。

- D. BigQuery で新しいデータセットを作成し、ソース テーブルを新しいデータセットにコピーします。新しいデータセットとテーブルを CLI からクエリします。

Answer: A

Question 066

アプリケーションは Compute Engine で実行されており、少数のリクエストで持続的な障害が発生しています。

原因を 1 つの Compute Engine インスタンスに絞り込みましたが、インスタンスが SSH に応答しませんでした。

何をするべきでしょうか?

- A. マシンを再起動します。

- B. シリアルポートの出力を有効にして確認します。

- C. マシンを削除して、新しいマシンを作成します。

- D. ディスクのスナップショットを取り、新しいマシンに使用します。

Answer: B

Question 067

全体的な CPU 使用率に応じて自動的にスケーリングするように Compute Engine インスタンス グループを構成しました。

しかし、クラスタがインスタンスを追加し終わる前にアプリケーションのレスポンス レイテンシーが急激に増加します。インスタンス グループのオートスケーラー構成を変更することでエンドユーザーにより一貫したレイテンシー体験を提供したいと思います

どのような構成に変更するべきでしょうか?(回答は 2 つ)

- A. インスタンス グループ テンプレートに AUTOSCALE というラベルを追加します。

- B. グループに追加されたインスタンスのクールダウン期間を短縮します。

- C. インスタンス グループ オートスケーラーのターゲット CPU 使用率を増やします。

- D. インスタンス グループ オートスケーラーのターゲット CPU 使用率を減らします。

- E. インスタンス グループ内の個々の VM のヘルスチェックを削除します。

Answer: B, D

Question 068

マネージド インスタンス グループで管理されているアプリケーションがあります。

アプリケーションの新バージョンをデプロイする場合、コストを最小限に抑え、インスタンスの数を増やすことができません。新しいインスタンスが作成されるたびに新しいインスタンスが健全である場合にのみデプロイが継続されるようにしたいと思います。

どうすればいいのでしょうか?

- A. maxSurge を 1、maxUnavailable を 0 に設定し、ローリングアクションを実行する。

- B. maxSurge を 0、maxUnavailable を 1 に設定し、ローリングアクションを実行します。

- C. maxHealthy を 1、maxUnhealthy を 0 に設定し、ローリングアクションを実行します。

- D. maxHealthy を 0、maxUnhealthy を 1 に設定し、ローリングアクションを実行します。

Answer: B

Reference:

– MIG で VM 構成の更新を自動的に適用する | Compute Engine ドキュメント | Google Cloud

Question 069

アプリケーションではホストの Compute Engine 仮想マシン インスタンスに保存されている認証情報を使用して GCP プロダクトに対してサービス アカウントを認証する必要があります。

これらの認証情報をホスト インスタンスにできるだけ安全に配布する必要があります。

どうすればいいでしょうか?

- A. HTTP 署名付き URL を使用し、必要なリソースへのアクセスを安全に提供します。

- B. インスタンスのサービス アカウント Application Default Credentials を使用し、必要なリソースを認証します。

- C. インスタンスのデプロイ後に Google Cloud コンソールから P12 ファイルを生成し、アプリケーションを開始する前に資格情報をホスト インスタンスにコピーします。

- D. 認証情報 JSON ファイルをアプリケーションのソース リポジトリにコミットし、CI / CD プロセスでインスタンスにデプロイされたソフトウェアと一緒にパッケージ化します。

Answer: B

Reference:

– Compute Engine へのリクエストの承認 | Compute Engine ドキュメント | Google Cloud

Question 070

アプリケーションは Google Kubernetes Engine (GKE) クラスタにデプロイされます。

このアプリケーションを Cloud Load Balancing HTTP(S) 負荷分散用の外部で公開したいと考えています。

どうすればいいでしょうか?

- A. GKE Ingress リソースを構成します。

- B. GKE Service リソースを構成します。

- C. タイプ:LoadBalancer で GKE Ingress リソースを構成します。

- D. タイプ:LoadBalancer の GKE Service リソースを構成します。

Answer: A

Reference:

– HTTP(S) 負荷分散用 GKE Ingress | Google Kubernetes Engine(GKE) | Google Cloud

Question 071

会社はオンプレミスの Hadoop 環境をクラウドに移行することを計画しています。

HDFS に保存されているデータのストレージ コストとメンテナンスの増大は会社にとって大きな懸念事項です。また、既存のデータ分析ジョブや既存のアーキテクチャへの変更は最小限に抑えたいと考えています。

どのように移行を進めるべきでしょうか?

- A. Hadoop に保存されているデータを BigQuery に移行します。オンプレミスの Hadoop 環境ではなく BigQuery から情報を取得するようにジョブを変更します。

- B. SSD の代わりに HDD を使用して Compute Engine インスタンスを作成し、コストを節約します。次に既存の環境を Compute Engine インスタンスの新しい環境に完全に移行します。

- C. Google Cloud Platform で Dataproc クラスタを作成し、Hadoop 環境を新しい Dataproc クラスタに移行します。HDFS データをより大きな HDD ディスクに移動して、ストレージ コストを節約します。

- D. Google Cloud Platform で Dataproc クラスタを作成し、Hadoop コード オブジェクトを新しいクラスタに移行します。データを Cloud Storage に移動し、Dataproc コネクタを利用してそのデータに対してジョブを実行します。

Answer: D

Question 072

データは Cloud Storage バケットに保存されます。

仲間の開発者は Cloud Storage からダウンロードしたデータが原因で API のパフォーマンスが低下していると報告しています。問題を調査して Google Cloud サポート チームに詳細を提供したいと考えています。

どのコマンドを実行する必要がありますか?

- A. gsutil test “o output.json gs://my-bucket

- B. gsutil perfdiag “o output.json gs://my-bucket

- C. gcloud compute scp example-instance:~/test-data “o output.json gs://my-bucket

- D. gcloud services test “o output.json gs://my-bucket

Answer: B

Reference:

– Sometimes get super-slow download rates from Google Cloud Storage, severely impacting workflow

Question 073

Cloud Build build を使用して Docker イメージを開発、テスト、本番の各環境にプロモートしようとしています。

同じ Docker イメージがこれらの各環境にデプロイされることを確実にする必要があります。

ビルドの Docker イメージはどのように識別するべきでしょうか?

- A. 最新の Docker イメージタグを使用します。

- B. 一意の Docker イメージ名を使用します。

- C. Docker イメージのダイジェストを使用します。

- D. セマンティック バージョニングの Docker イメージ タグを使用します。

Answer: C

Question 074

会社はレポートを Cloud Storage バケットにアップロードするアプリケーションを作成しました。

レポートがバケットにアップロードされたらメッセージを Cloud Pub/Sub トピックにパブリッシュします。実装に少しの労力がかかるソリューションを実装したいと考えています。

どうすればいいでしょうか?

- A. オブジェクトが変更されたときに Cloud Pub/Sub 通知をトリガーするように Cloud Storage バケットを構成します。

- B. ファイルを受け取る App Engine アプリケーションを作成します。受信したらメッセージを Cloud Pub/Sub トピックにパブリッシュします。

- C. Cloud Storage バケットによってトリガーされる Cloud Functions を作成します。Cloud Functions で Cloud Pub/Sub トピックにメッセージを発行します。

- D. ファイルを受信するために Google Kubernetes Engine クラスタにデプロイされたアプリケーションを作成します。受信したらメッセージを Cloud Pub/Sub トピックにパブリッシュします。

Answer: A

Reference:

– Pub/Sub notifications for Cloud Storage

Question 075

チームメイトから Cloud Datastore のアカウント残高にクレジットを追加する以下のコードを確認するように依頼されました。

チームメイトにどのような改善をするべきでしょうか?

public Entity creditAccount (long accountId, long creditAmount) {

Entity account = datastore.get

(keyFactory.newKey (accountId));

account = Entity.builder (account).set(

"balance", account.getLong ("balance") + creditAmount).build()

datastore.put (account);

return account;

}- A.祖先クエリでエンティティを取得します。

- B. エンティティを取得してトランザクションに入れます。

- C. 強力で一貫性のあるトランザクション データベースを使用します。

- D. 関数からアカウント エンティティを返しません。

Answer: B

Question 076

会社ではソースコードを Cloud Source Repositories リポジトリに保存しています。

会社はソース コードがリポジトリにコミットされるたびにコードをビルドしてテストしたいと考えており、管理され、運用オーバーヘッドが最小限のソリューションを必要としています。

どのような方法を使用するべきでしょうか?

- A. ソースコードのコミットごとに構成されたトリガーで Cloud Build を使用します。

- B. Google Cloud Marketplace 経由でデプロイされ、ソースコードのコミットを監視するように構成された Jenkins を使用します。

- C. ソースコードのコミットを監視するように構成されたオープンソースの継続的インテグレーション ツールで Compute Engine 仮想マシン インスタンスを使用します。

- D. ソース コード コミット トリガーを使用し、App Engine サービスをトリガーしてソース コードをビルドする Cloud Pub/Sub トピックにメッセージをプッシュします。

Answer: A

Question 077

プロジェクト B の Cloud Pub/Sub トピックに対して安全に認証する必要があるプロジェクト A で Compute Engine がホストするアプリケーションを作成しています。

どうすればいいでしょうか?

- A. プロジェクト B が所有するサービス アカウントを使用してインスタンスを構成します。サービス アカウントを Cloud Pub/Sub パブリッシャーとしてプロジェクト A に追加します。

- B. プロジェクト A が所有するサービス アカウントを使用してインスタンスを構成します。サービス アカウントをトピックのパブリッシャーとして追加します。

- C. プロジェクト B が所有するサービス アカウントの秘密鍵を使用するようにアプリケーションのデフォルト認証情報を構成します。サービス アカウントを Cloud Pub/Sub パブリッシャーとしてプロジェクト A に追加します。

- D. プロジェクト A が所有するサービス アカウントの秘密鍵を使用するようにアプリケーションの既定の資格情報を構成します。トピックのパブリッシャーとしてサービス アカウントを追加します。

Answer: B

Question 078

Compute Engine で財務部門用の企業ツールを開発しており、ユーザーを認証して財務部門の人間であることを確認する必要があります。

どうすればいいでしょうか?

- A. HTTP(s) ロードバランサの Cloud Identity-Aware Proxy を有効にし、財務部門のユーザーを含む Google グループにアクセスを制限します。提供された JSON Web トークンをアプリケーション内で確認します。

- B. HTTP(s) ロードバランサの Cloud Identity-Aware Proxy を有効にし、財務部門のユーザーを含む Google グループへのアクセスを制限します。財務チームの全員にクライアント側証明書を発行し、アプリケーションで証明書を検証します。

- C. Cloud Armor Security Policies を構成して企業 IP アドレス範囲のみにアクセスを制限します。提供された JSON Web トークンをアプリケーション内で検証します。

- D. Cloud Armor Security Policiesを構成して企業の IP アドレス範囲のみにアクセスを制限します。財務チームの全員にクライアント側の証明書を発行し、アプリケーションで証明書を検証します。

Answer: A

Question 079

API バックエンドが複数のクラウド プロバイダで実行されています。

API のネットワーク遅延に関するレポートを生成したいと考えています。

どのような手順で実行するべきでしょうか?(回答は 2 つ)

- A. Zipkin コレクタを使用してデータを収集します。

- B. Fluentd エージェントを使用してデータを収集します。

- C. Stackdriver Trace を使用してレポートを生成します。

- D. Stackdriver Debugger を使用してレポートを生成します。

- E. Stackdriver Profiler を使用してレポートを生成します。

Answer: A、C

Question 080

この問題は HipLocal のケーススタディを参照してください。

ユーザー アクティビティを保存するために HipLocal が使用するべきデータベースはどれでしょうか?

- A. BigQuery

- B. Cloud SQL

- C. Cloud Spanner

- D. Cloud Datastore

Answer: A

Question 081

この問題は HipLocal のケーススタディを参照してください。

HipLocal はアクセス制御を構成しています。

どのようなファイアウォール構成を実装するべきでしょうか?

- A. ポート 443 ですべてのトラフィックをブロックします。

- B. ネットワークへのすべてのトラフィックを許可します。

- C. 特定のタグのポート 443 でトラフィックを許可します。

- D. ネットワークへのポート 443 のすべてのトラフィックを許可します。

Answer: C

Question 082

この問題は HipLocal のケーススタディを参照してください。

HipLocal のデータ サイエンス チームはユーザー レビューを分析したいと考えています。

どのようにデータを準備するべきでしょうか?

- A. レビュー データセットの秘匿化には Cloud Data Loss Prevention API を使用します。

- B. Cloud Data Loss Prevention API を使用してレビュー データセットの匿名化を行います。

- C. レビュー データセットの秘匿化に Cloud Natural Language Processing API を使用します。

- D. Cloud Natural Language Processing API を使用してレビュー データセットの匿名化を行います。

Answer: B

Question 083

この問題は HipLocal のケーススタディを参照してください。

HipLocal がアプリケーションの状態を保存し、規定されたビジネス要件を満たすにはどのデータベース サービスに移行するべきでしょうか?

- A. Cloud Spanner

- B. Cloud Datastore

- C. キャッシュとしての Cloud Memorystore

- D. リージョンごとに個別の Cloud SQL クラスタ

Answer:D

Question 084

本番環境にデプロイされたアプリケーションがあります。

新しいバージョンがデプロイされたらすべての本番トラフィックがアプリケーションの新しいバージョンにルーティングされるようにする必要があります。また、新しいバージョンに問題が発生した場合に元に戻せるように以前のバージョンをデプロイしたままにしておくことも必要です。

どのデプロイ戦略を使用するべきでしょうか?

- A. Blue/Green デプロイ戦略

- B. カナリア テスト戦略

- C. ローリング デプロイ戦略

- D. 再作成 デプロイ戦略

Answer: A

Question 085

既存の Apache / MySQL / PHP アプリケーション スタックを単一のマシンから Google Kubernetes Engine に移植しています。

アプリケーションをコンテナ化する方法を決定する必要があります。アプローチは可用性に関して Google が推奨するベスト プラクティスに従う必要があります。

どうするべきでしょうか?

- A. 各コンポーネントを個別のコンテナにパッケージ化します。実装プローブとライブネス プローブを実装します。

- B. アプリケーションを単一のコンテナにパッケージ化します。プロセス管理ツールを使用して、各コンポーネントを管理します。

- C. 各コンポーネントを個別のコンテナにパッケージ化します。スクリプトを使用してコンポーネントの起動を調整します。

- D. アプリケーションを単一のコンテナにパッケージ化します。コンテナへのエントリポイントとして bash スクリプトを使用し、各コンポーネントをバックグラウンド ジョブとして生成します。

Answer: A

Reference:

–コンテナ構築のおすすめの方法 | Cloud アーキテクチャ センター | Google Cloud

Question 086

Compute Engine インスタンスで起動するアプリケーションをソフトウェア開発プロセスの環境 (開発、QA、ステージング、本番) に対応する複数の異なるプロジェクトに分けて開発しています。

各プロジェクトのインスタンスのアプリケーション コードは同じですが構成が異なります。デプロイ中、各インスタンスはサービスを提供する環境に基づいてアプリケーションの構成を受け取る必要があります。このフローを構成するためのステップ数を最小限に抑えたいと考えています。

どうすればいいでしょうか?

- A. インスタンスを作成するときに gcloud コマンドを使用して起動スクリプトを構成し、正しい環境を示すプロジェクト名を決定します。

- B. 各プロジェクトでそれが提供する環境を値とするメタデータ キー環境を構成します。デプロイ ツールを使用してインスタンス メタデータをクエリし、環境値に基づいてアプリケーションを構成します。

- C. 選択したデプロイ ツールを各プロジェクトのインスタンスにデプロイします。デプロイ ジョブを使用してバージョン管理システムから適切な構成ファイルを取得し、各インスタンスにアプリケーションをデプロイするときに構成を適用します。

- D. 各インスタンスの起動中に environment という名前のインスタンス カスタム メタデータ キーを構成します。この値はインスタンスが提供する環境です。デプロイ ツールを使用してインスタンス メタデータをクエリし、環境値に基づいてアプリケーションを構成します。

Answer: B

Reference:

–VM メタデータについて | Compute Engine ドキュメント | Google Cloud

Question 087

顧客、注文、在庫のデータを Cloud Spanner 内のリレーショナル テーブルとして保存する e コマース アプリケーションを開発しています。

最近の負荷テスト中に Cloud Spanner のパフォーマンスが期待どおりに直線的にスケーリングしていないことがわかりました。

原因はどれでしょうか?

- A. 32 ビットの数値に 64 ビットの数値型を使用します。

- B. 任意精度の値に対する STRING データ型を使用します。

- C. 単調に増加する主キーとしてのバージョン 1 UUID を使用します。

- D. パラメータ化された SQL クエリの STARTS_WITH キーワードの代わりに LIKE を使用します。

Answer:C

Question 088

Cloud Pub/Sub サブスクリプションからクレジット カード データを読み取るアプリケーションを開発しています。

コードを記述し、単体テストを完了しました。Google Cloud にデプロイする前に Cloud Pub/Sub 統合をテストする必要があります。

どうすればいいでしょうか?

- A. メッセージを発行するサービスを作成し、Cloud Pub/Sub エミュレーターをデプロイします。パブリッシング サービスでランダムなコンテンツを生成し、エミュレーターにパブリッシュします。

- B. アプリケーションにメッセージを発行するサービスを作成します。本番環境の Cloud Pub/Sub からメッセージを収集し、パブリッシング サービスを通じてそれらを再生します。

- C. メッセージを発行するサービスを作成し、Cloud Pub/Sub エミュレーターをデプロイします。本番環境の Cloud Pub/Sub からメッセージを収集し、エミュレーターに公開します。

- D. メッセージを発行するサービスを作成し、Cloud Pub/Sub エミュレーターをデプロイします。パブリッシング サービスからエミュレータにテスト メッセージの標準セットをパブリッシュします。

Answer:D

Question 089

単一の Cloud Pub/Sub トピックにサブスクライブしてメッセージを受信し、対応する行をデータベースに挿入するアプリケーションを設計しています。

アプリケーションは Linux で実行され、プリエンプティブル仮想マシンを活用してコストを削減します。正常なシャットダウンを開始するシャットダウン スクリプトを作成する必要があります。

どうすればいいでしょうか?

- A. プロセス間シグナルを使用してデータベースから切断するようにアプリケーション プロセスに通知するシャットダウン スクリプトを記述します。

- B. サインインしているすべてのユーザーに Compute Engine インスタンスがダウンするというメッセージをブロードキャストし、現在の作業を保存してサインアウトするように指示するシャットダウン スクリプトを作成します。

- C. アプリケーションによって 5 分ごとにポーリングされる場所にファイルを書き込むシャットダウン スクリプトを作成します。ファイルが読み取られた後、アプリケーションはデータベースから切断されます。

- D. シャットダウンが進行中であることを通知するメッセージを Pub/Sub トピックにパブリッシュするシャットダウン スクリプトを作成します。アプリケーションはメッセージを読み取った後、データベースから切断します。

Answer: A

Reference:

–シャットダウン スクリプトの実行 | Compute Engine ドキュメント | Google Cloud

Question 090

小さなスタートアップ企業の Web 開発チームで働いています。

チームは Cloud Storage や Cloud Build などの Google Cloud サービスを使用して Node.js アプリケーションを開発しており、バージョン管理に Git リポジトリを使用しています。上司から週末に電話があり、会社の Web サイトの 1 つを緊急に更新するように指示されました。開発者はあなただけです。仕事用のラップトップを持っておらず、会社以外のコンピュータにソースコードをローカルに保存することは許可されていません。

開発者 環境をどのように設定しますか?

- A. テキスト エディターと Git コマンド ラインを使用して公共のコンピューターからソース コードの更新をプル リクエストとして送信します。

- B. テキスト エディターと Git コマンド ラインを使用して公共のコンピューターで実行されている仮想マシンからソース コードの更新をプル リクエストとして送信します。

- C. Cloud Shell と組み込みのコード エディタを開発に使用してソース コードの更新をプル リクエストとして送信します。

- D. Cloud Storage バケットを使用して編集が必要なソースコードを保存します。バケットを公共のコンピューターにドライブとしてマウントし、コード エディターを使用してコードを更新します。バケットのバージョニングを有効にしてチームの Git リポジトリを参照します。

Answer:C

Reference:

–Contributing to projects – GitHub Enterprise Server 3.3 Docs

Question 091

チームは Google Kubernetes Engine で実行されるサービスを開発しています。

Google が推奨する手法を使用してログ データを標準化し、最小限の手順でデータをより有用なものにする必要があります。

どうすればいいでしょうか? (回答は 2 つ)

- A. ログ分析を容易にするために BigQuery へのアプリケーション ログの集約エクスポートを作成します。

- B. ログ分析を容易にするために Cloud Storage へのアプリケーション ログの集約エクスポートを作成します。

- C. ログ出力を単一行の JSON として標準出力 (stdout) に書き込み、構造化ログとして Cloud Logging に取り込みます。

- D. アプリケーション コードで Logging API を使用して構造化されたログを Cloud Logging に書き込むことを義務付けます。

- E. Pub/Sub API を使用して構造化データを Pub/Sub に書き込み、Dataflow ストリーミング パイプラインを作成してログを正規化し、分析のために BigQuery に書き込むことを義務付けます。

Answer:A、D

Question 092

Google Cloud での新しいアプリケーションのデプロイ手法を設計しています。

デプロイ計画の一環として、ライブ トラフィックを使用して新しいアプリケーションと既存のアプリケーションの両方のパフォーマンス メトリックを収集したいと考えています。起動前に完全な実稼働負荷に対してテストする必要があります。

どうすればいいでしょうか?

- A. カナリア テスト戦略を使用します。

- B. Blue/Green デプロイ戦略を使用します。

- C. ローリングアップデート デプロイ戦略を使用します。

- D. デプロイ時にトラフィック ミラーリングで A/B テスト戦略を使用します。

Answer:D

Reference:

–アプリケーションのデプロイとテストの戦略 | Cloud アーキテクチャ センター | Google Cloud

Question 093

Cloud Storage API を使用するアプリケーションをサポートしています。

ログを確認し、API からの複数の HTTP 503 Service Unavailable エラー応答を発見しました。アプリケーションはエラーをログに記録し、それ以上のアクションは実行しません。成功率を向上させるために Google が推奨する再試行ロジックを実装したいと考えています。

どのアプローチを取るべきですか?

- A. 設定された数の失敗がログに記録された後、バッチで失敗を再試行します。

- B. 設定された時間間隔で最大回数まで各失敗を再試行します。

- C. 最大試行回数まで時間間隔を増やしながら各失敗を再試行します。

- D. 最大試行回数まで時間間隔を減らしながら各失敗を再試行します。

Answer:C

Question 094

認証サービスからの監査イベントの取り込みを再設計してトラフィックの大幅な増加を処理できるようにする必要があります。

現在、監査サービスと認証システムは同じ Compute Engine 仮想マシンで実行されています。新しいアーキテクチャで次の Google Cloud ツールを使用する予定です。

– それぞれが認証サービスのインスタンスを実行する複数の Compute Engine マシン

– それぞれが監査サービスのインスタンスを実行する複数の Compute Engine マシン

– 認証サービスからイベントを送信するための Cloud Pub/Sub。

システムが大量のメッセージを処理し、効率的にスケーリングできるようにするにはトピックとサブスクリプションをどのように設定する必要がありますか?

- A. Cloud Pub/Sub トピックを 1 つ作成します。Pull サブスクリプションを 1 つ作成して監査サービスがメッセージを共有できるようにします。

- B. Cloud Pub/Sub トピックを 1 つ作成します。監査サービス インスタンスごとに 1 つの Pull サブスクリプションを作成してサービスがメッセージを共有できるようにします。

- C. Cloud Pub/Sub トピックを 1 つ作成します。エンドポイントが監査サービスの前にあるロードバランサを指す 1 つの Push サブスクリプションを作成します。

- D. 認証サービスごとに 1 つの Cloud Pub/Sub トピックを作成します。1 つの監査サービスで使用されるトピックごとに 1 つの Pull サブスクリプションを作成します。

- E. 認証サービスごとに 1 つの Cloud Pub/Sub トピックを作成します。トピックごとに 1 つの Push サブスクリプションを作成し、エンドポイントが 1 つの監査サービスを指すようにします。

Answer: A

Question 095

Google Cloud で実行される有名なステートレス Web アプリケーションを開発しています。

トラフィックがない日もあれば、急増する日もあるなど、ユーザーからのトラフィックは予測不可能できません。アプリケーションを自動的にスケールアップおよびスケールダウンする必要があり、アプリケーションの実行に関連するコストを最小限に抑える必要があります。

どうすればいいでしょうか?

- A. Cloud Firestore をデータベースとして Python でアプリケーションを構築します。アプリケーションを Cloud Run にデプロイします。

- B. Cloud Firestore をデータベースとして C# でアプリケーションを構築します。アプリケーションを App Engine フレキシブル環境にデプロイします。

- C. Cloud SQL をデータベースとして Python でアプリケーションを構築します。アプリケーションを App Engine スタンダード環境にデプロイします。

- D. Cloud Firestore をデータベースとして Python でアプリケーションを構築します。自動スケーリングを使用して、アプリケーションを Compute Engine マネージド インスタンス グループにデプロイします。

Answer: A

Question 096

他の Google Cloud リソースにアクセスする Cloud Functions を作成しました。

最小権限の原則を使用して環境を保護したいと考えています。

どうすればいいでしょうか?

- A. リソースにアクセスするための編集者 権限を持つ新しいサービス アカウントを作成します。デプロイ担当者にはアクセス トークンを取得するためのアクセス許可が与えられます。

- B. リソースにアクセスするためのカスタム IAM ロールを持つ新しいサービス アカウントを作成します。デプロイ担当者にはアクセス トークンを取得するためのアクセス許可が与えられます。

- C. リソースにアクセスするための編集者権限を持つ新しいサービス アカウントを作成します。デプロイ担当者には、新しいサービス アカウントとして機能する権限が与えられます。

- D. リソースにアクセスするためのカスタム IAM ロールを持つ新しいサービス アカウントを作成します。デプロイ担当者には新しいサービス アカウントとして機能する権限が与えられます。

Answer:D

Reference:

–Least privilege for Cloud Functions using Cloud IAM | Google Cloud Blog

Question 097

Google Kubernetes Engine (GKE) クラスタ内の顧客に専用のブログ ソフトウェアをデプロイする SaaS プロバイダがいます。

各顧客が自分のブログにのみアクセスでき、他の顧客のワークロードに影響を与えないように安全なマルチテナント プラットフォームを構成したいと考えています。

どうすればいいでしょうか?

- A. GKE クラスタでアプリケーション レイヤのシークレットを有効にしてクラスタを保護します。

- B. テナントごとに名前空間をデプロイして各ブログのデプロイでネットワーク ポリシーを使用します。

- C. GKE Audit Logging を使用して悪意のあるコンテナを特定し、検出時に削除する。

- D. ブログ ソフトウェアのカスタム イメージを構築し、Binary Authorization を使用して信頼できないイメージのデプロイを防止します。

Answer: B

Reference:

–クラスタ マルチテナンシー | Google Kubernetes Engine(GKE) | Google Cloud

Question 098

Compute Engine アプリケーションを Google Kubernetes Engine に移行することにしました。

コンテナ イメージをビルドし、Cloud Build を使用して Artifact Registry にプッシュする必要があります。

どうすればいいでしょうか? (回答は 2 つ)

- A. アプリケーションのソースコードを含むディレクトリで gcloud builds submit を実行します。

- B. アプリケーションのソース コードを含むディレクトリで gcloud run deploy app-name –image gcr.io/$PROJECT_ID/app-name を実行します。

- C. アプリケーション ソース コードを含むディレクトリで gcloud container images add-tag gcr.io/$PROJECT_ID/app-name gcr.io/$PROJECT_ID/app-name:latest を実行します。

- D. アプリケーション ソース ディレクトリで次の内容を含む cloudbuild.yaml という名前のファイルを作成します。

name: ‘gcr.io/cloud-builders/docker’

steps:

args: [‘build’, ‘-t’, ‘gcr.io/$PROJECT_ID/app-name’, ‘.’]

name: ‘gcr.io/cloud-buliders/docker’

args: [‘push’, ‘gcr.io$PROJECT_ID/app-name’] - E. アプリケーション ソース ディレクトリで次の内容を含む cloudbuild.yaml という名前のファイルを作成します。

contents:

steps:

name: ‘gcr.io/cloud-builders/gcloud’

args: [‘app’, ‘deploy’]

timeout: ‘1600s’

Answer:A、D

Question 099

従業員が社内でコミュニティ イベントを開催できるようにする社内アプリケーションを開発しています。

単一の Compute Engine インスタンスにアプリケーションをデプロイしました。会社は Google Workspace (旧:G Suite) を使用しており、会社の従業員がどこからでもアプリケーションに対して認証できるようにする必要があります。

どうすればいいでしょうか?

- A. インスタンスにパブリック IP アドレスを追加し、ファイアウォール ルールを使用してインスタンスへのアクセスを制限します。会社のプロキシを唯一の送信元 IP アドレスとして許可します。

- B. インスタンスの前に HTTP(S) ロードバランサを追加し、Identity-Aware Proxy (IAP) を設定します。会社のドメインが Web サイトにアクセスできるように IAP 設定を構成します。

- C. 会社のネットワークと Google Cloud のインスタンスの VPC ロケーションの間に VPN トンネルを設定します。必要なファイアウォール ルールとルーティング情報をオンプレミス ネットワークと Google Cloud ネットワークの両方に構成します。

- D. インスタンスにパブリック IP アドレスを追加し、インターネットからのトラフィックを許可します。ランダム ハッシュを生成し、このハッシュを含み、インスタンスを指すサブドメインを作成します。この DNS アドレスを会社の従業員に配布します。

Answer: B

Question 100

開発チームは App Engine で構築した Node.js アプリケーションをステージング環境から本番環境に移行するために Cloud Build を使用しています。

このアプリケーションはステージング環境の webphotos-staging という名前の Cloud Storage バケットに保存されている写真の複数のディレクトリに依存しています。移行後、これらの写真は本番環境の webphotos-prod という名前の Cloud Storage バケットで利用できる必要があります。可能であればプロセスを自動化したいとも考えています。

どうすればいいでしょうか?

- A. 写真を webphotos-prod に手動でコピーします。

- B. アプリケーションの app.yami ファイルに起動スクリプトを追加して写真を webphotos-staging から webphotos-prod に移動します。

- C. 移行ステップの前に引数を使用して cloudbuild.yaml ファイルにビルド ステップを追加します。

name: ‘gcr.io/cloud-builders/gsutil

args: [‘cp’, ‘-r’, ‘gs://webphotos-staging’, ‘gs://webphotos-prod’]

waitFor: [‘-‘] - D. 移行ステップの前に引数を使用して cloudbuild.yaml ファイルにビルド ステップを追加します。

name: gcr.io/cloud-builders/gcloud

args: [‘cp’, ‘-A’, ‘gs://webphotos-staging’, ‘gs://webphotos-prod’]

waitFor: [‘-‘]

Answer:C

Question 101

HTTP と HTTPS の両方でアクセスでき、Compute Engine インスタンスで実行される Web アプリケーションを開発しています。

アプリのメンテナンスを行うためにリモート ラップトップから Compute Engine インスタンスの 1 つに SSH 接続する必要がある場合があります。

Google が推奨するベスト プラクティスに従いながらインスタンスをどのように構成するべきでしょうか?

- A. TCP プロキシ ロードバランサの背後にあるプライベート IP アドレスを使用して、Compute Engine の Web サーバ インスタンスでバックエンドを設定します。

- B. ファイアウォール ルールを構成して、すべてのメッシュの上り(内向き)トラフィックが Compute Engine の Web サーバに接続できるようにします。各サーバには一意の外部 IP アドレスがあります。

- C. SSH アクセス用に Cloud Identity-Aware Proxy API を構成します。次にアプリケーション Web トラフィック用の HTTP(S) ロードバランサの背後にあるプライベート IP アドレスを使用して Compute Engine サーバを構成します。

- D. HTTP(S) ロードバランサの外部にあるプライベート IP アドレスを使用して Compute Engine の Web サーバ インスタンスでバックエンドを設定します。パブリック IP アドレスを使用して要塞ホストを設定し、ファイアウォール ポートを開きます。要塞ホストを使用して Web インスタンスに接続します。

Answer:C

Reference:

–高度な方法による Linux VM への接続 #TCP 用 Identity-Aware Proxy(IAP)を介した接続 | Compute Engine ドキュメント | Google Cloud

Question 102

Linux を実行している Compute Engine インスタンスでホストされているパッケージ化されたアプリケーションと社内で開発されたアプリケーションが混在しています。

これらのアプリケーションは、ログ レコードをテキストとしてローカル ファイルに書き込み、ログを Cloud Logging に書き込む必要があります。

どうすればいいでしょうか?

- A. ファイルの内容を Linux Syslog デーモンにパイプします。

- B. Google バージョンの fluentd を Compute Engine インスタンスにインストールします。

- C. Compute Engine インスタンスに Google バージョンの collectd をインストールします。

- D. cron を使用して 1 日 1 回ログ ファイルを Cloud Storage にコピーするジョブをスケジュールします。

Answer: B

Reference:

–Logging エージェントを構成する | Google Cloud

Question 103

アプリケーション用に「fully baked」または「golden」の Compute Engine イメージを作成する必要があります。

アプリケーションが実行されている環境 (テスト、ステージング、本番) に応じてアプリケーションをブートストラップして適切なデータベースに接続する必要があります。

どうすればいいでしょうか?

- A. 適切なデータベース接続文字列をイメージに埋め込み、環境ごとに異なるイメージを作成します。

- B. Compute Engine インスタンスを作成するときに接続するデータベースの名前を含むタグを追加します。アプリケーションで Compute Engine API にクエリを実行して現在のインスタンスのタグを取得し、そのタグを使用して適切なデータベース接続文字列を作成します。

- C. Compute Engine インスタンスを作成するときに DATABASE のキーと適切なデータベース接続文字列の値を持つメタデータ項目を作成します。アプリケーションで DATABASE 環境変数を読み取り、その値を使用して適切なデータベースに接続します。

- D. Compute Engine インスタンスを作成するときに DATABASE のキーと適切なデータベース接続文字列の値を持つメタデータ項目を作成します。アプリケーションで、メタデータ サーバに DATABASE 値をクエリし、その値を使用して適切なデータベースに接続します。

Answer:D

Question 104

Google Kubernetes Engine クラスタにデプロイされるマイクロサービス ベースのアプリケーションを開発しています。

アプリケーションは Cloud Spanner データベースの読み取りと書き込みを行う必要があります。コードの変更を最小限に抑えながらセキュリティのベスト プラクティスに従います。

Google Spanner 認証情報を取得するにはアプリケーションをどのように構成するべきでしょうか?

- A. 適切なサービス アカウントを構成し、Workload Identity を使用して Pod を実行します。

- B. アプリケーション資格情報を Kubernetes シークレットとして保存し、環境変数として公開します。

- C. 適切なルーティング ルールを構成し、VPC ネイティブ クラスタを使用してデータベースに直接接続する。

- D. Cloud Key Management Service を使用してアプリケーション資格情報を保存し、データベース接続が確立されるたびにそれらを取得します。

Answer: A

Reference:

–Google Kubernetes Engine から Cloud SQL に接続する | Cloud SQL for MySQL | Google Cloud

Question 105

Cloud SQL と通信する Compute Engine インスタンスにアプリケーションをデプロイしています。

Cloud SQL Proxy を使用してアプリケーションのインスタンスに関連付けられたサービス アカウントを使用し、アプリケーションがデータベースと通信できるようにします。サービス アカウントに割り当てられたロールに最小限のアクセスを提供するという、Google が推奨するベスト プラクティスに従います。

どうすればいいでしょうか?

- A. プロジェクト編集者の役割を割り当てます。

- B. プロジェクト所有者の役割を割り当てます。

- C. Cloud SQL クライアントの役割を割り当てます。

- D. Cloud SQL 編集者の役割を割り当てます。

Answer:C

Reference:

–Cloud SQL Auth Proxy について | Cloud SQL for MySQL | Google Cloud

Question 106

チームは Google Kubernetes Engine (GKE) で実行されるステートレス サービスを開発しています。

GKE クラスタで実行されている他のサービスのみがアクセスできる新しいサービスをデプロイする必要があります。サービスは変化する負荷に対応するためにできるだけ迅速にスケーリングする必要があります。

どうすればいいでしょうか?

- A. Vertical Pod Autoscaler を使用してコンテナをスケーリングし、ClusterIP サービスを介して公開します。

- B. Vertical Pod Autoscaler を使用してコンテナをスケーリングし、NodePort サービスを介して公開します。

- C. Horizontal Pod Autoscaler を使用してコンテナをスケーリングし、ClusterIP サービスを介して公開します。

- D. Horizontal Pod Autoscaler を使用してコンテナをスケーリングし、NodePort サービスを介して公開します。

Answer:C

Question 107

最近、モノリシック アプリケーションをマイクロサービスに分割して Google Cloud に移行しました。

マイクロサービスの 1 つは Cloud Functions を使用してデプロイされます。アプリケーションをモダナイズするときに下位互換性のないサービスの API に変更を加えます。元の API を使用する既存の呼び出し元と新しい API を使用する新しい呼び出し元の両方をサポートする必要があります。

どうすればいいでしょうか?

- A. 元の Cloud Functions をそのままにして新しい API を使用して 2 つ目の Cloud Functions をデプロイします。ロードバランサを使用してバージョン間で呼び出しを分散します。

- B. 元の Cloud Functions をそのままにして変更された API のみを含む 2 つ目の Cloud Functions をデプロイします。呼び出しは、正しい関数に自動的にルーティングされます。

- C. 元の Cloud Functions をそのままにして、新しい API を使用して 2 つ目の Cloud Functions をデプロイします。Cloud Endpoints を使用してバージョン管理された API を公開する API ゲートウェイを提供します。

- D. 新しい API をサポートするためにコードを変更した後、Cloud Functions を再デプロイします。API の両方のバージョンに対する要求は呼び出しに含まれるバージョン識別子に基づいて実行されます。

Answer:C

Question 108

ユーザーがニュース記事のコメントを読んだり投稿したりできるアプリケーションを開発しています。

Cloud Firestore を使用してユーザーが送信したコメントを保存および表示するようにアプリケーションを構成したいと考えています。

不明な数のコメントと記事をサポートするにはスキーマをどのように設計するべきでしょうか?

- A. 各コメントを記事のサブコレクションに保存します。

- B. 各コメントを記事の配列プロパティに追加します。

- C. 各コメントをドキュメントに保存し、コメントのキーを記事の配列プロパティに追加します。

- D. 各コメントをドキュメントに保存し、コメントのキーをユーザー プロファイルの配列プロパティに追加します。

Answer:D

Question 109

最近、アプリケーションを開発しました。

パブリック IP アドレスを持たない Compute Engine インスタンスから Cloud Storage API を呼び出す必要があります。

どうすればいいでしょうか?

- A. キャリア ピアリングを使用します。

- B. VPC ネットワーク ピアリングを使用します。

- C. 共有 VPC ネットワークを使用します。

- D. 限定公開の Google アクセスを使用します。

Answer:D

Reference:

–IP アドレス | Compute Engine ドキュメント | Google Cloud

Question 110

CI / CD チームと協力してチームが導入した新機能のトラブルシューティングを行う開発者です。

CI / CD チームは HashiCorp Packer を使用して開発ブランチから新しい Compute Engine イメージを作成しました。イメージは正常にビルドされましたが起動していません。CI / CD チームで問題を調査する必要があります。

どうすればいいでしょうか?

- A. 新しい機能ブランチを作成し、ビルド チームにイメージの再構築を依頼します。

- B. デプロイされた仮想マシンをシャットダウンし、ディスクをエクスポートしてからディスクをローカルにマウントしてブート ログにアクセスします。

- C. Packer をローカルにインストールし、Compute Engine イメージをローカルでビルドしてから個人の Google Cloud プロジェクトで実行します。

- D. シリアル ポートを使用して Compute Engine OS のログを確認し、Cloud Logging のログを確認してシリアル ポートへのアクセスを確認します。

Answer:D

Reference:

– Jenkins、Packer、Kubernetes を使用したイメージ構築の自動化 | Cloud アーキテクチャ センター | Google Cloud

Question 111

Compute Engine インスタンスで実行されるアプリケーションを管理します。また、Compute Engine インスタンスで実行されているスタンドアロンの Docker コンテナで複数のバックエンド サービスを実行しています。

バックエンド サービスをサポートする Compute Engine インスタンスは複数のリージョンのマネージド インスタンス グループによってスケーリングされます。呼び出し元のアプリケーションを疎結合にしたいと考えています。リクエストで見つかった HTTP ヘッダーの値に基づいて選択された個別のサービス実装を呼び出すことができる必要があります。

バックエンド サービスを呼び出すにはどの Google Cloud 機能を使用するべきでしょうか?

- A. Traffic Director

- B. Service Directory

- C. Anthos サービス メッシュ

- D. 内部 HTTP(S) ロードバランサ

Answer: A

Reference:

– Traffic Director | Google Cloud

Question 112

チームは会社の e コマース プラットフォームを開発しています。

ユーザーは Web サイトにログインし、ショッピング カートに商品を追加します。ユーザーは 30 分間操作がないと自動的にログアウトされます。ユーザーが再度ログインするとショッピング カートが保存されます。

Google が推奨するベスト プラクティスに従ってユーザーのセッションとショッピング カートの情報をどのように保存しますか?

- A. セッション情報を CLoud Pub/Sub に保存し、ショッピング カート情報を Cloud SQL に保存する。

- B. ショッピング カートの情報をファイル名が SESSION ID である Cloud Storage 上のファイルに保存します。

- C. セッションとショッピング カートの情報を複数の Compute Engine インスタンスで実行されている MySQL データベースに保存します。

- D. セッション情報を Memorystore for Redis または Memorystore for Memcached に保存し、ショッピング カート情報を Cloud Firestore に保存します。

Answer:D

Question 113

Google Kubernetes Engine クラスタ内のさまざまなチームが使用するアプリケーションのリソース共有ポリシーを設計しています。

すべてのアプリケーションが実行に必要なリソースにアクセスできるようにする必要があります。

どうすればいいでしょうか? (回答は 2 つ)

- A. オブジェクト仕様でリソースの制限と要求を指定します。

- B. 各チームの名前空間を作成し、リソース クォータを各名前空間に添付します。

- C. LimitRange を作成して各名前空間のデフォルトのコンピューティング リソース要件を指定します。

- D. アプリケーションごとに Kubernetes サービス アカウント (KSA) を作成し、各 KSA を名前空間に割り当てます。

- E. Anthos Policy Controller を使用してすべての名前空間にラベル アノテーションを適用します。taints と tolerations を使用して名前空間のリソース共有を許可します。

Answer:B、C

Reference:

– Kubernetes サービス アカウントを使用する | Google Kubernetes Engine(GKE) | Google Cloud

Question 114

次の設計要件を持つ新しいアプリケーションを開発しています。

– アプリケーション インフラストラクチャの作成と変更はバージョン管理され、監査可能です。

– アプリケーションおよびデプロイ インフラストラクチャは Google マネージド サービスを可能な限り使用します。

– アプリケーションはサーバレス コンピューティング プラットフォームで実行されます。

アプリケーションのアーキテクチャをどのように設計する必要がありますか?

- A.

- 1. アプリケーションとインフラストラクチャのソース コードを Git リポジトリに保存します。

- 2. Cloud Build を使用して Terraform でアプリケーション インフラストラクチャをデプロイします。

- 3. アプリケーションをパイプライン ステップとして Cloud Functions にデプロイします。

- B.

- 1. Google Cloud Marketplace から Jenkins をデプロイし、Jenkins で継続的インテグレーション パイプラインを定義します。

- 2. パイプライン ステップを構成して Git リポジトリからアプリケーション ソース コードをプルします。

- 3. アプリケーション ソース コードをパイプライン ステップとして App Engine にデプロイします。

- C.

- 1. Cloud Build で継続的インテグレーション パイプラインを作成し、Deployment Manager テンプレートを使用してアプリケーション インフラストラクチャをデプロイするようにパイプラインを構成します。

- 2. パイプライン ステップを構成して最新のアプリケーション ソース コードを含むコンテナを作成します。

- 3. コンテナをパイプライン ステップとして Compute Engine インスタンスにデプロイします。

- D.

- 1. gcloud コマンドを使用してアプリケーション インフラストラクチャをデプロイします。

- 2. Cloud Build を使用してアプリケーションのソースコードを変更するための継続的インテグレーション パイプラインを定義します。

- 3. Git リポジトリからアプリケーション ソース コードをプルするパイプライン ステップを構成し、コンテナ化されたアプリケーションを作成します。

4. 新しいコンテナをパイプライン ステップとして Cloud Run にデプロイします。

Answer: A

Reference:

–Google Cloud での CI / CD

Question 115

Google Cloud のさまざまなプロジェクトでコンテナを作成して実行しています。

開発中のアプリケーションは Google Kubernetes Engine (GKE) 内から Google Cloud サービスにアクセスする必要があります。

どうすればいいでしょうか?

- A. Google サービス アカウントを GKE ノードに割り当てます。

- B. Google サービス アカウントを使用して Workload Identity で Pod を実行します。

- C. Google サービス アカウントの資格情報を Kubernetes シークレットとして保存します。

- D. GKE ロールベースのアクセス制御 (RBAC) で Google サービス アカウントを使用する。

Answer: B

Question 116

NFS 共有に構成を格納するレガシー アプリケーションをコンテナ化しました。

このアプリケーションを Google Kubernetes Engine (GKE) にデプロイする必要があり、構成が取得されるまでアプリケーションがトラフィックを処理しないようにする必要があります。

どうすればいいでしょうか?

- A. gsutil ユーティリティを使用して起動時に Docker コンテナ内からファイルをコピーし、ENTRYPOINT スクリプトを使用してサービスを開始します。

- B. GKE クラスタに PersistentVolumeClaim を作成します。ボリュームから構成ファイルにアクセスし、ENTRYPOINT スクリプトを使用してサービスを開始します。

- C. Dockerfile で COPY ステートメントを使用して構成をコンテナ イメージにロードします。構成が使用可能であることを確認し、ENTRYPOINT スクリプトを使用してサービスを開始します。

- D. 起動スクリプトを GKE インスタンス グループに追加してノードの起動時に NFS 共有をマウントします。構成ファイルをコンテナにコピーし、ENTRYPOINT スクリプトを使用してサービスを開始します。

Answer: B

Reference:

–Linux VM での起動スクリプトの使用 | Compute Engine ドキュメント | Google Cloud

Question 117

チームは PostgreSQL データベースと Cloud Run を使用して新しいアプリケーションを開発しています。

すべてのトラフィックが Google Cloud で非公開に保たれるようにする責任があります。マネージド サービスを使用し、Google が推奨するベスト プラクティスに従います。

どうすればいいでしょうか?

- A.

- 1. 同じプロジェクトで Cloud SQL と Cloud Run を有効にします。

- 2. Cloud SQL のプライベート IP アドレスを構成し、プライベート サービス アクセスを有効にします。

- 3. サーバレス VPC アクセス コネクタを作成します。

- 4. コネクタを使用して Cloud SQL に接続するように Cloud Run を構成します。

- B.

- 1. PostgreSQL を Compute Engine 仮想マシン (VM) にインストールし、同じプロジェクトで Cloud Run を有効にします。

- 2. VM のプライベート IP アドレスを構成し、プライベート サービス アクセスを有効にします。

- 3. サーバレス VPC アクセス コネクタを作成します。

- 4. コネクタを使用して PostgreSQL をホストする VM に接続するように Cloud Run を構成します。

- C.

- 1. Cloud SQL と Cloud Run を異なるプロジェクトで使用します。

- 2. Cloud SQL のプライベート IP アドレスを構成し、プライベート サービス アクセスを有効にします。

- 3. サーバレス VPC アクセス コネクタを作成します。

- 4. 2 つのプロジェクト間に VPN 接続を設定し、コネクタを使用して Cloud SQL に接続するように Cloud Run を構成します。

- D.

- 1. Compute Engine VM に PostgreSQL をインストールし、さまざまなプロジェクトで Cloud Run を有効にします。

- 2. VM のプライベート IP アドレスを構成し、プライベート サービス アクセスを有効にします。

- 3. サーバレス VPC アクセス コネクタを作成します。

- 4. 2 つのプロジェクト間に VPN 接続を設定し、コネクタを使用して PostgreSQL をホストする VM にアクセスするように Cloud Run を構成します。

Answer: A

Question 118

クライアントが特定の期間、Web サイトからファイルをダウンロードできるようにするアプリケーションを開発しています。

Google が推奨するベスト プラクティスに従いながらこのタスクを完了するにはアプリケーションをどのように設計するべきでしょうか?

- A. ファイルを電子メールの添付ファイルとしてクライアントに送信するようにアプリケーションを構成します。

- B. ファイルの Cloud Storage 署名付き URL を生成して割り当てます。クライアントがダウンロードできる URL を作成します。

- C. 有効期限が指定された一時的な Cloud Storage バケットを作成し、バケットにダウンロード権限を付与します。ファイルをコピーし、クライアントに送信します。

- D. 有効期限が指定された HTTP Cookie を生成します。時間が有効な場合は Cloud Storage バケットからファイルをコピーし、クライアントがファイルをダウンロードできるようにします。

Answer: B

Question 119

開発チームは既存のモノリシック アプリケーションを構成可能な一連のマイクロサービスにリファクタリングするように依頼されました。

新しいアプリケーションに実装する必要のある設計要素はどれでしょうか? (回答は 2 つ)

- A. マイクロサービスの呼び出し元が使用するのと同じプログラミング言語でマイクロサービス コードを開発します。

- B. マイクロサービスの実装とマイクロサービスの呼び出し元の間で API コントラクト アグリーメントを作成します。

- C. すべてのマイクロサービス実装とマイクロサービス呼び出し元の間で非同期通信をリクエストします。

- D. パフォーマンス要件に対応するためにマイクロサービスの十分なインスタンスが実行されていることを確認します。

- E. 現在のインターフェースと互換性がなくなる可能性がある将来の変更を許可するバージョン管理スキームを実装します。

Answer: B

Question 120

新しいアプリケーションを Google Kubernetes Engine にデプロイしましたがパフォーマンスが低下しています。

ログは Cloud Logging に書き込まれ、Prometheus サイドカー モデルを使用して指標を取得しています。ログからのメトリックとデータを関連付けてパフォーマンスの問題をトラブルシューティングし、コストを最小限に抑えながらリアルタイムのアラートを送信する必要があります。

どうすればいいでしょうか?

- A. Cloud Logging ログからカスタム指標を作成し、Prometheus を使用して Cloud Monitoring REST API を使用して結果をインポートします。

- B. Cloud Logging のログと Prometheus 指標を Cloud Bigtable にエクスポートします。クエリを実行して結果を結合し、Google データポータルで分析します。

- C. Cloud Logging のログをエクスポートし、Prometheus 指標を BigQuery にストリーミングします。繰り返しクエリを実行して結果を結合し、Cloud Tasks を使用して通知を送信します。

- D. Prometheus 指標をエクスポートし、Cloud Monitoring を使用してそれらを外部指標として表示します。Cloud Monitoring を構成してログからログベースの指標を作成し、それらを Prometheus データと関連付けます。

Answer:D

Reference:

– Cloud Logging のモニタリング データによる GKE アプリのトラブルシューティング迅速化 | Google Cloud 公式ブログ

– Prometheus 指標の使用 | オペレーション スイート | Google Cloud

Question 121

オンプレミスから Google Cloud への会社のアプリケーションの移行を計画する任務を負っています。

会社のモノリシック アプリケーションは e コマース Web サイトです。アプリケーションは Google Cloud にデプロイされたマイクロサービスに段階的に移行されます。会社の収益の大部分はオンライン販売によって生み出されているため、移行中のリスクを最小限に抑えることが重要です。機能に優先順位を付け、移行する最初の機能を選択する必要があります。

どうすればいいでしょうか?

- A. フロントエンドと製品データベースに統合されている製品カタログを移行します。

- B. フロントエンド、注文データベース、サードパーティの支払いベンダーに統合された支払い処理を移行します。

- C.注文データベース、在庫システム、サードパーティの配送ベンダーと統合された注文フルフィルメントを移行します。

- D. フロントエンド、カート データベース、在庫システム、支払い処理システムに統合されたショッピング カートを移行します。

Answer: A

Question 122

チームは Google Kubernetes Engine で実行されるサービスを開発しています。

チームのコードは Cloud Source Repositories に保存されています。コードを本番環境にデプロイする前に、コードのバグをすばやく特定する必要があります。自動化に投資して開発者のフィードバックを改善し、プロセスをできるだけ効率的にしたいと考えています。

どうすればいいでしょうか?

- A. Spinnaker を使用して Git タグに基づくコードからコンテナ イメージの構築を自動化します。

- B. Cloud Build を使用して Git タグに基づくコードからコンテナ イメージのビルドを自動化します。

- C. Spinnaker を使用して本番環境へのコンテナ イメージのデプロイを自動化します。

- D. Cloud Build を使用してフォークされたバージョンに基づくコードからコンテナ イメージのビルドを自動化します。

Answer: B

Reference:

–Kubernetes Source to Prod | Spinnaker

Question 123

チームは Cloud Identity によって維持されるユーザー ID を使用して実行されるアプリケーションを Google Cloud で開発しています。

アプリケーションの各ユーザーにはメッセージが発行される関連付けられた Cloud Pub/Sub トピックと、同じユーザーが発行されたメッセージを取得する Cloud Pub/Sub サブスクリプションがあります。許可されたユーザーのみが、独自の特定の Cloud Pub/Sub トピックとサブスクリプションをパブリッシュ、サブスクライブできるようにする必要があります。

どうすればいいでしょうか?

- A. リソース レベルでユーザー ID を pubsub.publisher ロールと pubsub.subscriber ロールにバインドします。

- B. プロジェクト レベルでユーザー ID に pubsub.publisher ロールと pubsub.subscriber ロールを付与します。

- C. ユーザー ID に pubsub.topics.create、pubsub.subscriptions.create 権限を含むカスタム ロールを付与します。

- D. pubsub.publisher、pubsub.subscriber ロールを持つサービス アカウントとして実行するようにアプリケーションを構成します。

Answer: A

Question 124

Google Kubernetes Engine の採用と VS Code や IntelliJ を含む開発環境との統合を促進する開発者ツールを評価しています。

どうすればいいでしょうか?

- A. Cloud Code を使用してアプリケーションを開発します。

- B. Cloud Shell 統合コード エディタを使用してコードと構成ファイルを編集します。

- C. Cloud Notebook インスタンスを使用してデータを取り込んで処理し、モデルをデプロイします。

- D. Cloud Shell を使用してコマンドラインからインフラストラクチャとアプリケーションを管理します。

Answer: A

Reference:

–Cloud Code | Google Cloud

Question 125

App Engine スタンダード環境と Memorystore for Redis を使用する e コマース Web アプリケーションを開発しています。

ユーザーがアプリにログインするとアプリケーションはユーザーの情報 (セッション、名前、住所、設定など) をキャッシュします。この情報はチェックアウト時にすばやく取得できるように保存されます。ブラウザでアプリケーションをテストしているときに 502 Bad Gateway エラーが発生します。アプリケーションが Memorystore に接続していないと判断しました。

このエラーの理由は何でしょうか?

- A. Memorystore for Redis インスタンスがパブリック IP アドレスなしでデプロイされました。

- B. App Engine インスタンスとは異なるリージョンでサーバレス VPC アクセス コネクタを構成しました。

- C. DevOps チームによるインフラストラクチャのアップデート中に App Engine と Memorystore 間の接続を許可するファイアウォール ルールが削除されました。

- D. App Engine インスタンスとは異なる可用性の高いゾーンの別のサブネットでサーバレス VPC アクセス コネクタを使用するようにアプリケーションを構成しました。

Answer: B

Reference:

–レスポンス エラーのトラブルシューティング | OpenAPI を使用した Cloud Endpoints | Google Cloud

Question 126

チームは Google Cloud で実行されるサービスを開発しています。

データ処理サービスを構築する必要があり、Cloud Functions を使用します。関数によって処理されるデータは機密情報です。呼び出しが許可されたサービスからのみ行われるようにし、機能を保護するために Google が推奨するベスト プラクティスに従う必要があります。

どうすればいいでしょうか?

- A. プロジェクトで Identity-Aware Proxy を有効にし、権限を使用して機能アクセスを保護します。

- B. Cloud Functions ビューアーの役割を持つサービス アカウントを作成し、そのサービス アカウントを使用して関数を呼び出します。

- C. Cloud Functions Invoker ロールを持つサービス アカウントを作成し、そのサービス アカウントを使用して関数を呼び出します。

- D. 保護する関数と同じプロジェクトで呼び出し元サービスの OAuth 2.0 クライアント ID を作成し、これらの資格情報を使用して関数を呼び出します。

Answer:C

Question 127

アプリケーションを Compute Engine にデプロイしています。

Compute Engine インスタンスの 1 つを起動できませんでした。

どうすればいいでしょうか? (回答は 2 つ)

- A. ファイル システムが破損しているかどうかを確認します。

- B. 別の SSH ユーザーとして Compute Engine にアクセスします。

- C. インスタンスでのファイアウォール ルール、またはルートのトラブルシューティング。

- D. インスタンスの起動ディスクが完全にいっぱいかどうかを確認します。

- E. インスタンスとの間のネットワーク トラフィックがドロップされているかどうかを確認します。

Answer:A、D

Question 128

Web アプリケーションは企業のイントラネットにデプロイされます。

Web アプリケーションを Google Cloud に移行する必要があります。Web アプリケーションは会社の従業員のみが使用でき、出張中に従業員がアクセスできる必要があります。アプリケーションの変更を最小限に抑えながら Web アプリケーションのセキュリティとアクセシビリティを確保する必要があります。

どうすればいいでしょうか?

- A. アプリケーションへの HTTP(S) リクエストごとに認証資格情報を確認するようにアプリケーションを構成します。

- B. Identity-Aware Proxy を構成し、従業員がパブリック IP アドレスを介してアプリケーションにアクセスできるようにします。

- C. ユーザーに企業アカウントへのログインを要求する Compute Engine インスタンスを構成します。Web アプリケーションの DNS を変更してプロキシ Compute Engine インスタンスを指すようにします。認証後、Compute Engine インスタンスは Web アプリケーションとの間でリクエストを転送します。

- D. ユーザーに企業アカウントへのログインを要求する Compute Engine インスタンスを構成します。Web アプリケーションの DNS を変更してプロキシ Compute Engine インスタンスを指すようにします。認証後、Compute Engine は Web アプリケーションをホストするパブリック IP アドレスに HTTP リダイレクトを発行します。

Answer: B

Question 129

HTTP Cloud Functions を使用してデスクトップ ブラウザとモバイル アプリケーション クライアントの両方からのユーザー アクティビティを処理するアプリケーションがあります。

この関数は HTTP POST を使用したすべてのメトリック送信のエンドポイントとして機能します。従来の制限により、関数は Web またはモバイル セッションでユーザーがリクエストしたドメインとは別のドメインにマップする必要があります。Cloud Functions のドメインは https://fn.example.com です。デスクトップおよびモバイル クライアントはドメイン https://www.example.com を使用します。関数の HTTP レスポンスにヘッダーを追加してこれらのブラウザおよびモバイル セッションのみがメトリクスを Cloud Functions に送信できるようにする必要があります。

どのレスポンス ヘッダーを追加するべきでしょうか?

- A. Access-Control-Allow-Origin: *

- B. Access-Control-Allow-Origin: https://*.example.com

- C. Access-Control-Allow-Origin: https://fn.example.com

- D. Access-Control-Allow-origin: https://www.example.com

Answer:D

Question 130

POST 経由で呼び出される HTTP Cloud Functions があります。

各送信のリクエスト本文には数値データとテキスト データを含むフラットでネストされていない JSON 構造があります。Cloud Functions が完了すると収集されたデータは多くのユーザーが並行して進行中の複雑な分析にすぐに利用できるようになります。

サブミッションをどのように永続化する必要がありますか?

- A. 各 POST リクエストの JSON データを Datastore に直接永続化します。

- B. POST リクエストの JSON データを変換し、BigQuery にストリーミングします。

- C. POST リクエストの JSON データを変換し、リージョンの Cloud SQL クラスタに保存します。

- D. 各 POST リクエストの JSON データを個別のファイルとして Cloud Storage 内に保存し、ファイル名にリクエスト識別子を含めます。

Answer: B

Question 131

セキュリティ チームは Google Kubernetes Engine で実行されているすべてのデプロイ済みアプリケーションを監査しています。

監査を完了した後、チームは一部のアプリケーションがクラスタ内のトラフィックをクリア テキストで送信していることを発見しました。アプリケーションへの変更を最小限に抑え、Google からのサポートを維持しながら、すべてのアプリケーション トラフィックをできるだけ迅速に暗号化する必要があります。

どうすればいいでしょうか?

- A. ネットワーク ポリシーを使用し、アプリケーション間のトラフィックをブロックします。

- B. Istio をインストールし、アプリケーションの名前空間でプロキシ インジェクションを有効にしてから mTLS を有効にします。

- C. アプリケーション内で信頼できるネットワークの範囲を定義し、それらのネットワークからのトラフィックのみを許可するようにアプリケーションを構成します。

- D. 自動化されたプロセスを使用してアプリケーションの SSL 証明書を Let’s Encrypt から要求し、それらをアプリケーションに追加します。

Answer: B

Question 132

一部のアプリケーションを Google Cloud に移行しました。

オンプレミスとクラウドにデプロイされたアプリケーションの両方にオンプレミスにデプロイされた従来の監視プラットフォームを使用しています。クラウド アプリケーションのタイム クリティカルな問題に対する通知システムの応答が遅いことがわかりました。

どうすればいいでしょうか?

- A. モニタリング プラットフォームを Cloud Monitoring に置き換えます。

- B. Compute Engine インスタンスに Cloud Monitoring エージェントをインストールします。

- C. 一部のトラフィックを古いプラットフォームに戻します。2 つのプラットフォームで同時に A/B テストを実行します。

- D. Cloud Logging と Cloud Monitoring を使用してログを取得して監視し、アラートを送信します。それらを既存のプラットフォームに送信します。

Answer:D

Question 133

最近、Google Kubernetes Engine にアプリケーションをデプロイしましたがアプリケーションの新しいバージョンをリリースする必要があります。

新しいバージョンで問題が発生した場合に備え、以前のバージョンに即座にロールバックする機能が必要です。

どのデプロイ モデルを使用する必要がありますか?

- A. ローリング デプロイを実行し、デプロイ完了後に新しいアプリケーションをテストします。

- B. A/B テストを実行し、新しいテストが実装された後、定期的にアプリケーションをテストします。

- C. Blue/Green デプロイを実行し、デプロイ後に新しいアプリケーションをテストします。完了。

- D. カナリア デプロイを実行し、新しいバージョンのデプロイ後に新しいアプリケーションを定期的にテストします。

Answer:C

Question 134

Google ドライブの API にアクセスし、ユーザーからファイルを Google ドライブに保存する許可を取得する必要がある JavaScript Web アプリケーションを開発しました。

アプリケーションの承認アプローチを選択する必要があります。

どうすればいいでしょうか?

- A. API キーを作成します。

- B. SAML トークンを作成します。

- C. サービス アカウントを作成します。

- D. OAuth クライアント ID を作成します。

Answer:D

Reference:

–API 固有の承認および認証情報 | Google Drive | Google Developers

Question 135

後にそれらの購入をキャンセルまたは変更できる顧客からの購入を処理する e コマース アプリケーションを管理します。

注文量が非常に変動しやすく、バックエンドの注文処理システムが一度に 1 つの要求しか処理できないことがわかりました。使用量に関係なく、顧客のためにシームレスなパフォーマンスを確保したいと考えています。顧客の注文更新リクエストは生成された順序で実行されることが重要です。

どうすればいいでしょうか?

- A. WebSocket を介して購入および変更要求をバックエンドに送信します。

- B. 購入と変更のリクエストを REST リクエストとしてバックエンドに送信します。

- C. pull モードで Cloud Pub/Sub サブスクライバーを使用し、Datastore を使用して注文を管理します。

- D. push モードで Cloud Pub/Sub サブスクライバーを使用し、Datastore を使用して注文を管理します。

Answer:C

Reference:

– pull サブスクリプション | Cloud Pub/Sub ドキュメント | Google Cloud

Question 136

会社は顧客の購入履歴を保存し、次の要件を満たすデータベース ソリューションを必要としています。

– 顧客は送信後すぐに購入を照会できます。

– さまざまなフィールドで購入をソートできます。

– 異なるレコード形式を同時に保存できます。

これらの要件を満たすストレージ オプションはどれでしょうか?

- A. ネイティブ モードの Cloud Firestore

- B. オブジェクト読み取りを使用した Cloud Storage

- C. SQL SELECT ステートメントを使用した Cloud SQL

- D. グローバル クエリを使用した Datastore モードの Cloud Firestore

Answer: A

Question 137

最近、Cloud Run で新しいサービスを開発しました。

新しいサービスはカスタム サービスを使用して認証し、トランザクション情報を Cloud Spanner データベースに書き込みます。発生するボトルネックを特定しながら、アプリケーションが最大 5,000 の読み取り/秒 および 1,000 の書き込み/秒 トランザクションをサポートできることを確認する必要があり、テスト インフラストラクチャは自動スケーリングできる必要があります。

どうすればいいでしょうか?

- A. テスト ハーネスを構築してリクエストを生成し、それを Cloud Run にデプロイします。Cloud Logging を使用して VPC フロー ログを分析します。

- B. 負荷テストを動的に生成するために Locust または JMeter イメージを実行する Google Kubernetes Engine クラスタを作成します。Cloud Trace を使用して結果を分析します。

- C. Cloud Task を作成してテスト負荷を生成する。Cloud Scheduler を使用して 1 分あたり 60,000 の Cloud Task トランザクションを 10 分間実行します。Cloud Monitoring を使用して結果を分析します。

- D. Marketplace の LAMP スタック イメージを使用する Compute Engine インスタンスを作成し、Apache Bench を使用してサービスに対する負荷テストを生成します。Cloud Trace を使用して結果を分析します。

Answer: B

Question 138

CI / CD パイプラインに Cloud Build を使用して特定のファイルを Compute Engine 仮想マシンにコピーするなど、いくつかのタスクを完了しています。

パイプラインでは同じパイプライン内の後続のビルダーがアクセスできるようにパイプライン内の 1 つのビルダーで生成されたフラット ファイルが必要です。

パイプライン内のすべてのビルダーがファイルにアクセスできるようにするにはファイルをどのように保存するべきでしょうか?

- A. Compute Engine インスタンスのメタデータを使用し、ファイルの内容を保存および取得します。

- B. ファイルの内容を /workspace のファイルに出力します。後続のビルド ステップで同じ /workspace ファイルから読み取ります。

- C. gsutil を使用し、ファイルの内容を Cloud Storage オブジェクトに出力します。後続のビルド ステップで同じオブジェクトから読み取ります。

- D. curl を介して HTTP POST を実行するビルド引数を別の Web サーバに追加して 1 つのビルダーで値を保持します。後続のビルド ステップから curl 経由で HTTP GET を使用して、値を読み取ります。

Answer: B

Question 139

会社の開発チームは Docker ビルドでさまざまなオープン ソース オペレーティング システムを使用したいと考えています。

会社の環境で公開されたコンテナでイメージが作成された場合、それらをスキャンして Common Vulnerabilities and Exposures (CVE) を探す必要があります。スキャン プロセスがソフトウェア開発の俊敏性に影響を与えてはなりません。可能な限りマネージド サービスを使用したいと考えています。

どうすればいいでしょうか?

- A. Container Registry で脆弱性スキャン設定を有効にします。

- B. コードのチェックインでトリガーされる Cloud Functions を作成し、CVE のコードをスキャンします。

- C. 開発環境で非商用ベース イメージの使用を禁止します。